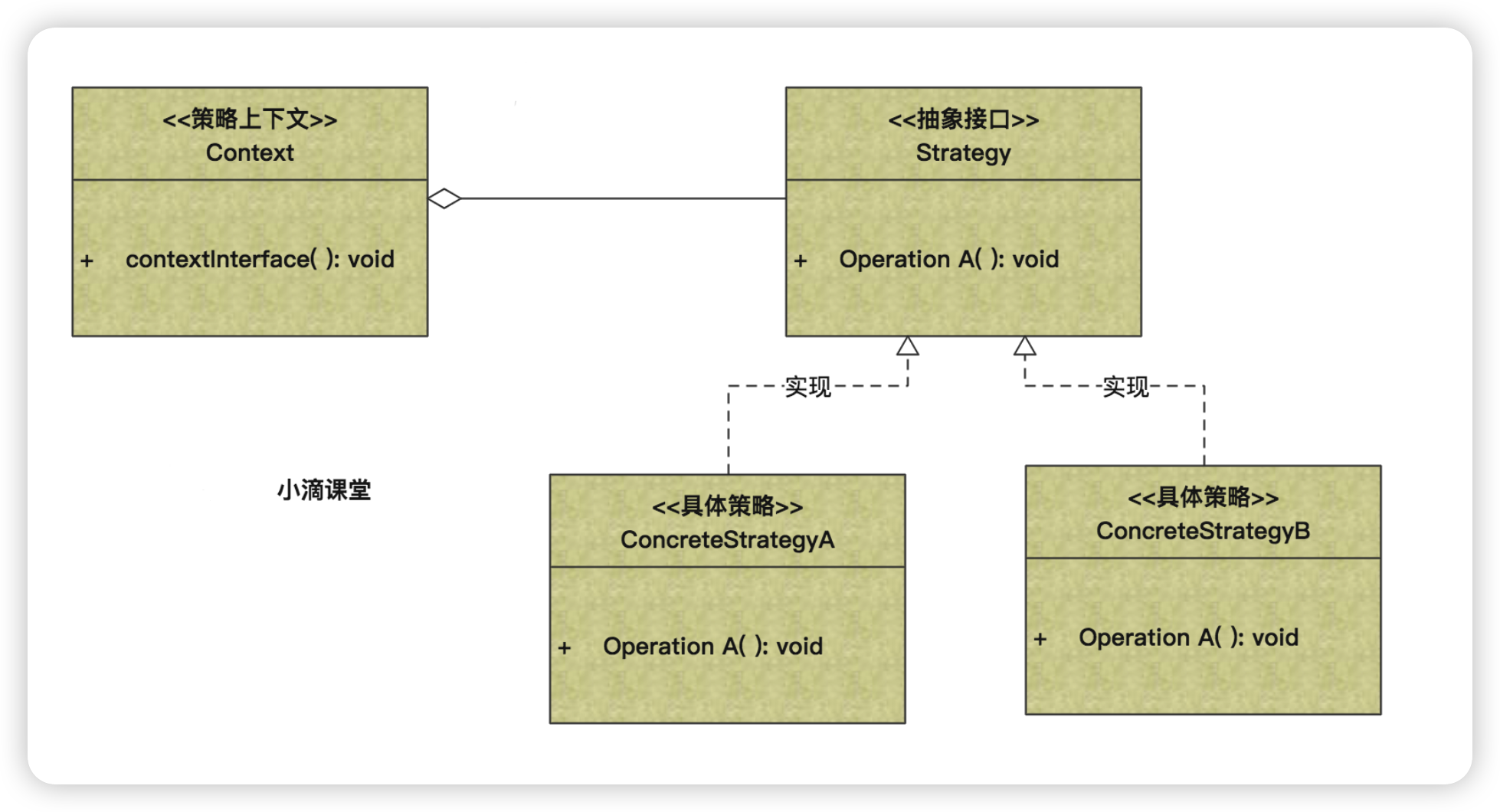

* 应用场景

- 外出旅游,选择骑自行车、坐汽车、飞机等,每一种旅行方式都是一个策略

- 如果在一个系统里面有许多类,它们之间的区别仅在于它们的行为,那么可以使用策略模式

- 不希望暴露复杂的、与算法有关的数据结构,那么可以使用策略模式来封装算法

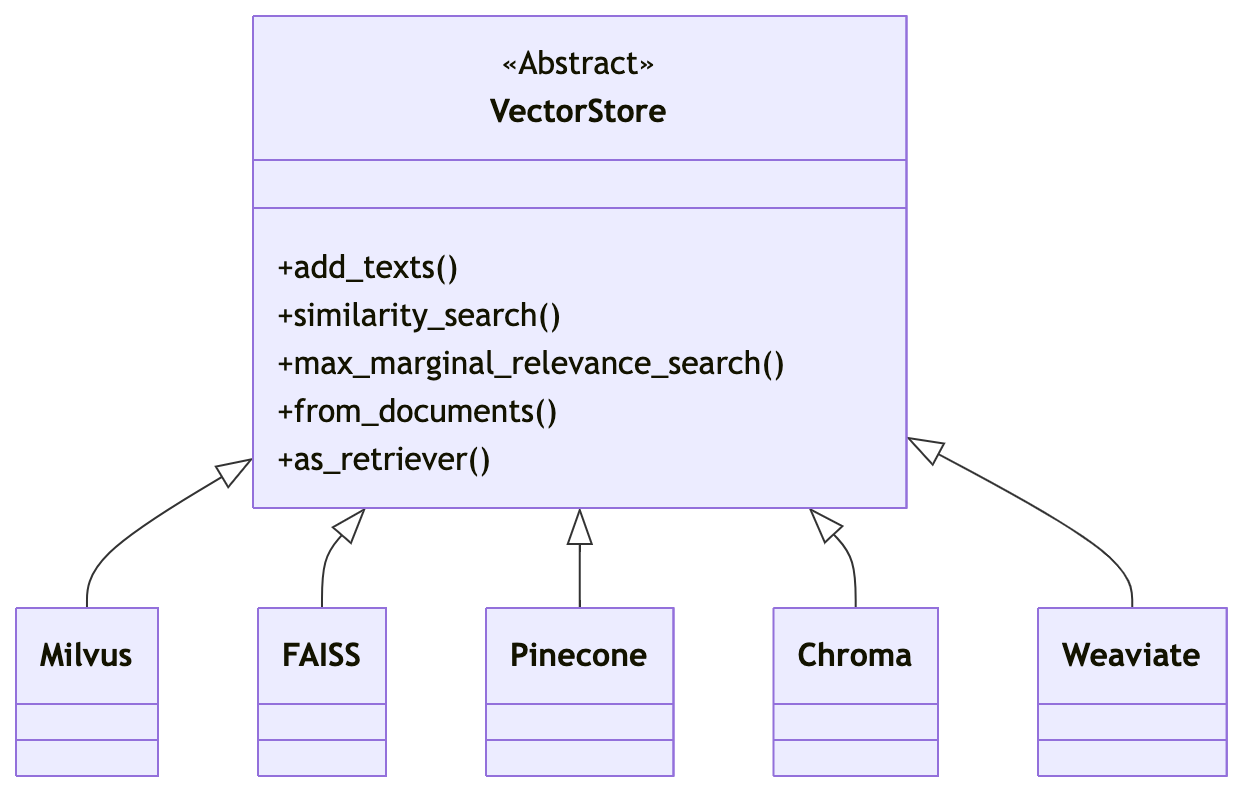

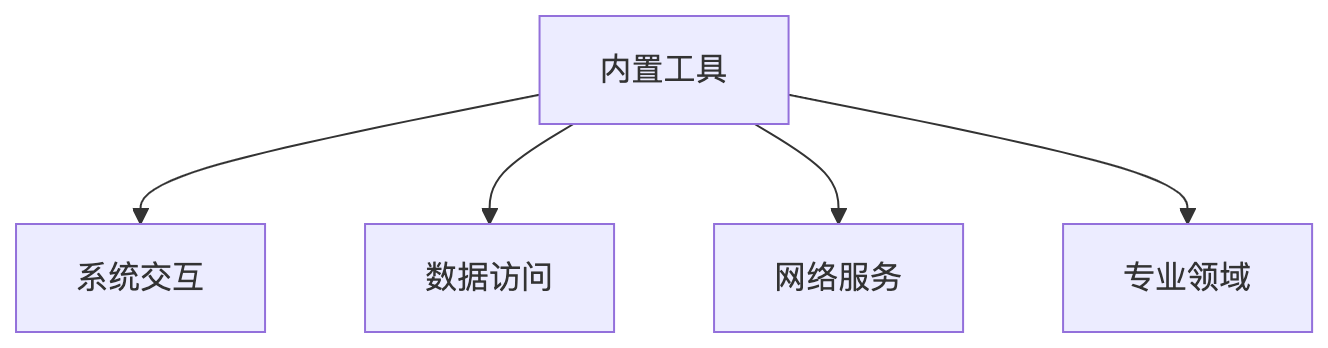

* 为什么要抽象存储引擎接口

* 将文件存储引擎的接口抽象出来,具体实现可以多种,提高系统的灵活性和可维护性。

* 允许我们根据不同的需求和环境(如开发、测试、生产)灵活切换不同的存储解决方案

* 优点

- **灵活性和可扩展性**:通过定义一个统一的存储接口,我们可以在不修改客户端代码的情况下引入新的存储解决方案。

- **解耦**:将存储逻辑从业务逻辑中解耦,使得存储引擎的变化不影响业务逻辑。

- **易于测试**:可以针对接口编写单元测试,而不必依赖具体的存储实现。

- **代码复用**:多个项目可以共享相同的存储接口,提高代码复用率。

- **简化维护**:统一的接口使得维护和更新存储逻辑变得更加简单。

* 缺点

- **复杂性增加**:需要额外定义接口和可能的抽象类,增加了系统的复杂性。

- **性能考虑**:接口调用可能引入额外的性能开销,尤其是在接口频繁调用的情况下。

- **实现一致性**:确保所有存储策略实现都遵循相同的接口规范,需要严格的代码审查和测试。

* 注意

* **其实aws-java-sdk-s3本身就是封装好了,支持多个存储的,为啥我们又要加一层呢???**

* 假想下

* 万一我以后不用aws-java-sdk-s3,那岂不是四处要修改aws-java-sdk-s3的API方法

* 但如果我加了一层,其他地方使用的话,后续修改换别的SDK,我只需要修改我自己封装的那层即可

#### SpringBoot3.X整合MinIO存储AWS-S3封装

封装存储引擎接口设计【常规版】

* * 定义一个名为StorageEngine的接口,包含多个方法

* 可以跟进需求,实现`StorageEngine`接口的不同存储策略

- **LocalFileStorageEngine**:使用本地文件系统作为存储。

- **S3StorageEngine**:使用Amazon S3作为存储。

- **DatabaseStorageEngine**:使用数据库存储文件元数据和内容。

- **MinIOStorageEngine**:使用MinIO存储文件内容。

- ...

* 使用策略模式的优势

- **客户端代码与存储实现解耦**:客户端代码只需与`StorageEngine`接口交互,不需要关心具体的存储细节。

- **易于切换存储策略**:根据不同的业务需求或环境(开发、测试、生产)灵活切换不同的存储策略。

- **支持A/B测试**:可以同时运行多个存储策略,进行性能和效果比较。

* 抽取文件操作相关接口 StoreEngine

```java

public interface StoreEngine {

/*=====================Bucket相关===========================*/

/**

* 检查指定的存储桶是否存在于当前的存储系统中

*

* @param bucketName 存储桶的名称

* @return 如果存储桶存在,则返回true;否则返回false

*/

boolean bucketExists(String bucketName);

/**

* 删除指定名称的存储桶

*

* @param bucketName 存储桶的名称

* @return 如果存储桶删除成功,则返回true;否则返回false

*/

boolean removeBucket(String bucketName);

/**

* 创建一个新的存储桶

*

* @param bucketName 新存储桶的名称

*/

void createBucket(String bucketName);

/**

* 获取当前存储系统中的所有存储桶列表

*

* @return 包含所有存储桶的列表

*/

List

* 应用场景

- 外出旅游,选择骑自行车、坐汽车、飞机等,每一种旅行方式都是一个策略

- 如果在一个系统里面有许多类,它们之间的区别仅在于它们的行为,那么可以使用策略模式

- 不希望暴露复杂的、与算法有关的数据结构,那么可以使用策略模式来封装算法

* 为什么要抽象存储引擎接口

* 将文件存储引擎的接口抽象出来,具体实现可以多种,提高系统的灵活性和可维护性。

* 允许我们根据不同的需求和环境(如开发、测试、生产)灵活切换不同的存储解决方案

* 优点

- **灵活性和可扩展性**:通过定义一个统一的存储接口,我们可以在不修改客户端代码的情况下引入新的存储解决方案。

- **解耦**:将存储逻辑从业务逻辑中解耦,使得存储引擎的变化不影响业务逻辑。

- **易于测试**:可以针对接口编写单元测试,而不必依赖具体的存储实现。

- **代码复用**:多个项目可以共享相同的存储接口,提高代码复用率。

- **简化维护**:统一的接口使得维护和更新存储逻辑变得更加简单。

* 缺点

- **复杂性增加**:需要额外定义接口和可能的抽象类,增加了系统的复杂性。

- **性能考虑**:接口调用可能引入额外的性能开销,尤其是在接口频繁调用的情况下。

- **实现一致性**:确保所有存储策略实现都遵循相同的接口规范,需要严格的代码审查和测试。

* 注意

* **其实aws-java-sdk-s3本身就是封装好了,支持多个存储的,为啥我们又要加一层呢???**

* 假想下

* 万一我以后不用aws-java-sdk-s3,那岂不是四处要修改aws-java-sdk-s3的API方法

* 但如果我加了一层,其他地方使用的话,后续修改换别的SDK,我只需要修改我自己封装的那层即可

#### SpringBoot3.X整合MinIO存储AWS-S3封装

封装存储引擎接口设计【常规版】

* * 定义一个名为StorageEngine的接口,包含多个方法

* 可以跟进需求,实现`StorageEngine`接口的不同存储策略

- **LocalFileStorageEngine**:使用本地文件系统作为存储。

- **S3StorageEngine**:使用Amazon S3作为存储。

- **DatabaseStorageEngine**:使用数据库存储文件元数据和内容。

- **MinIOStorageEngine**:使用MinIO存储文件内容。

- ...

* 使用策略模式的优势

- **客户端代码与存储实现解耦**:客户端代码只需与`StorageEngine`接口交互,不需要关心具体的存储细节。

- **易于切换存储策略**:根据不同的业务需求或环境(开发、测试、生产)灵活切换不同的存储策略。

- **支持A/B测试**:可以同时运行多个存储策略,进行性能和效果比较。

* 抽取文件操作相关接口 StoreEngine

```java

public interface StoreEngine {

/*=====================Bucket相关===========================*/

/**

* 检查指定的存储桶是否存在于当前的存储系统中

*

* @param bucketName 存储桶的名称

* @return 如果存储桶存在,则返回true;否则返回false

*/

boolean bucketExists(String bucketName);

/**

* 删除指定名称的存储桶

*

* @param bucketName 存储桶的名称

* @return 如果存储桶删除成功,则返回true;否则返回false

*/

boolean removeBucket(String bucketName);

/**

* 创建一个新的存储桶

*

* @param bucketName 新存储桶的名称

*/

void createBucket(String bucketName);

/**

* 获取当前存储系统中的所有存储桶列表

*

* @return 包含所有存储桶的列表

*/

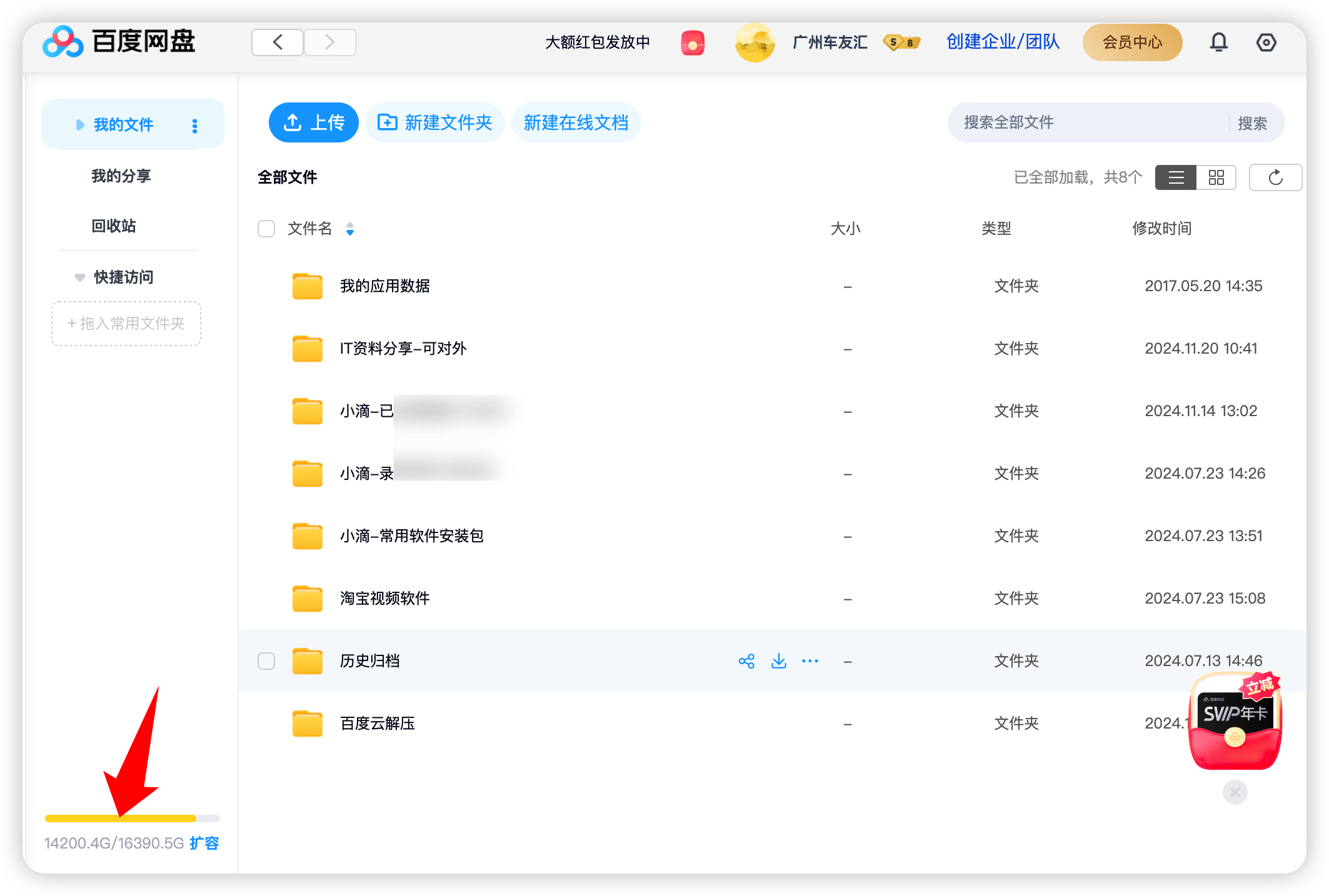

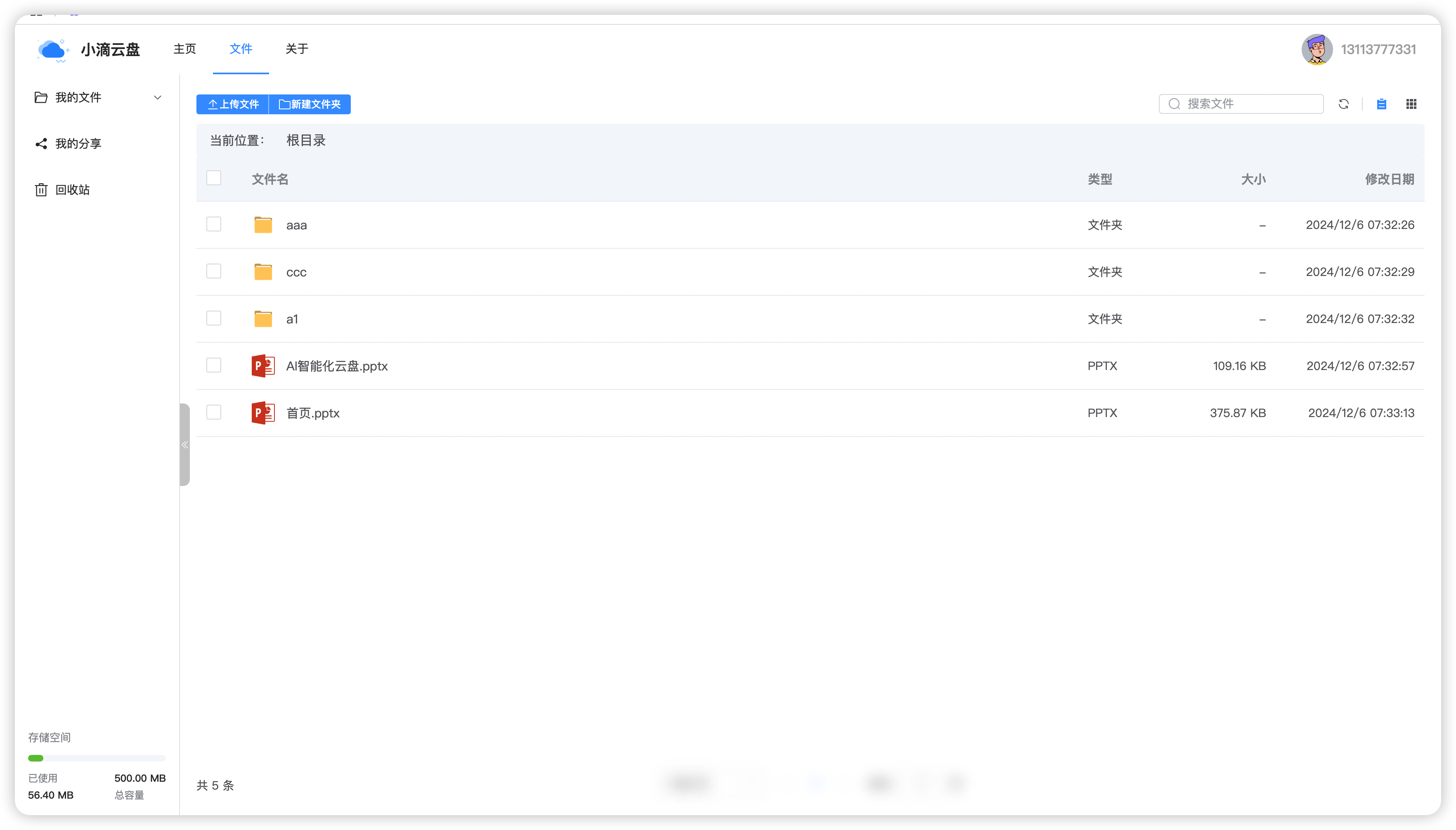

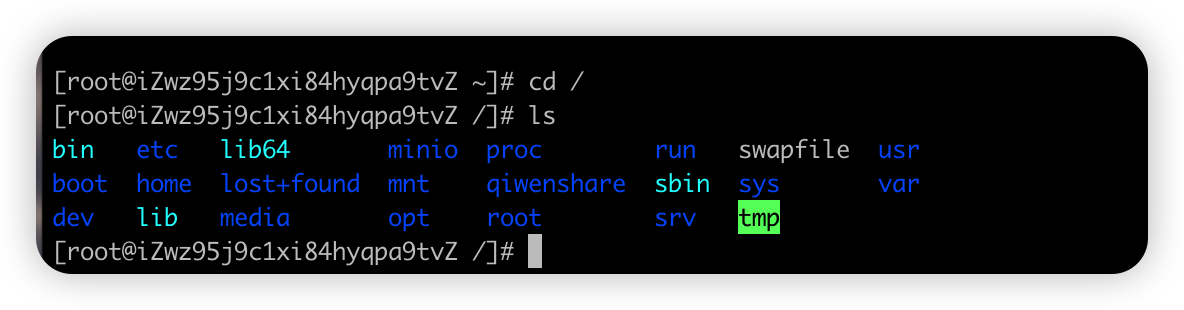

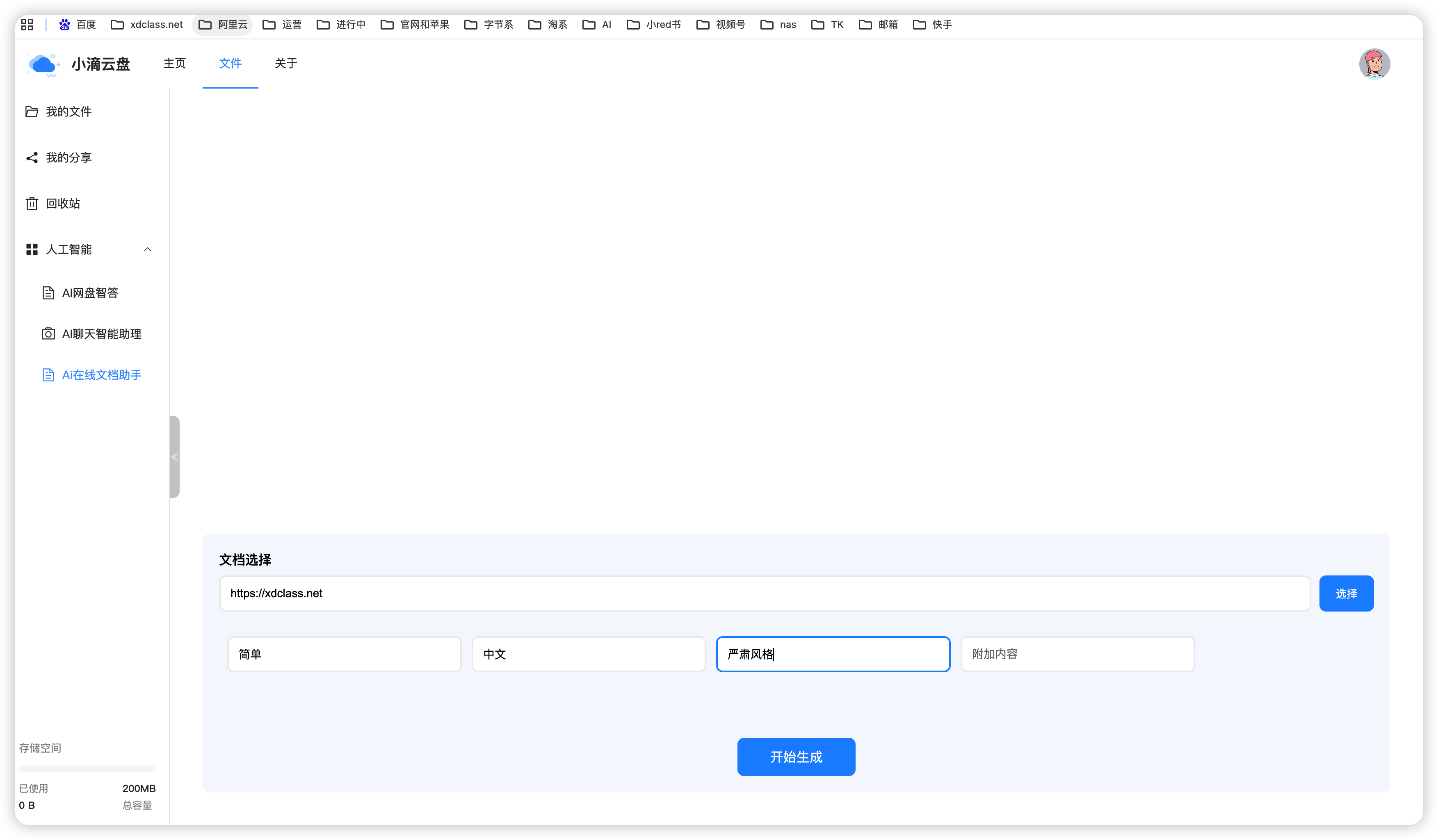

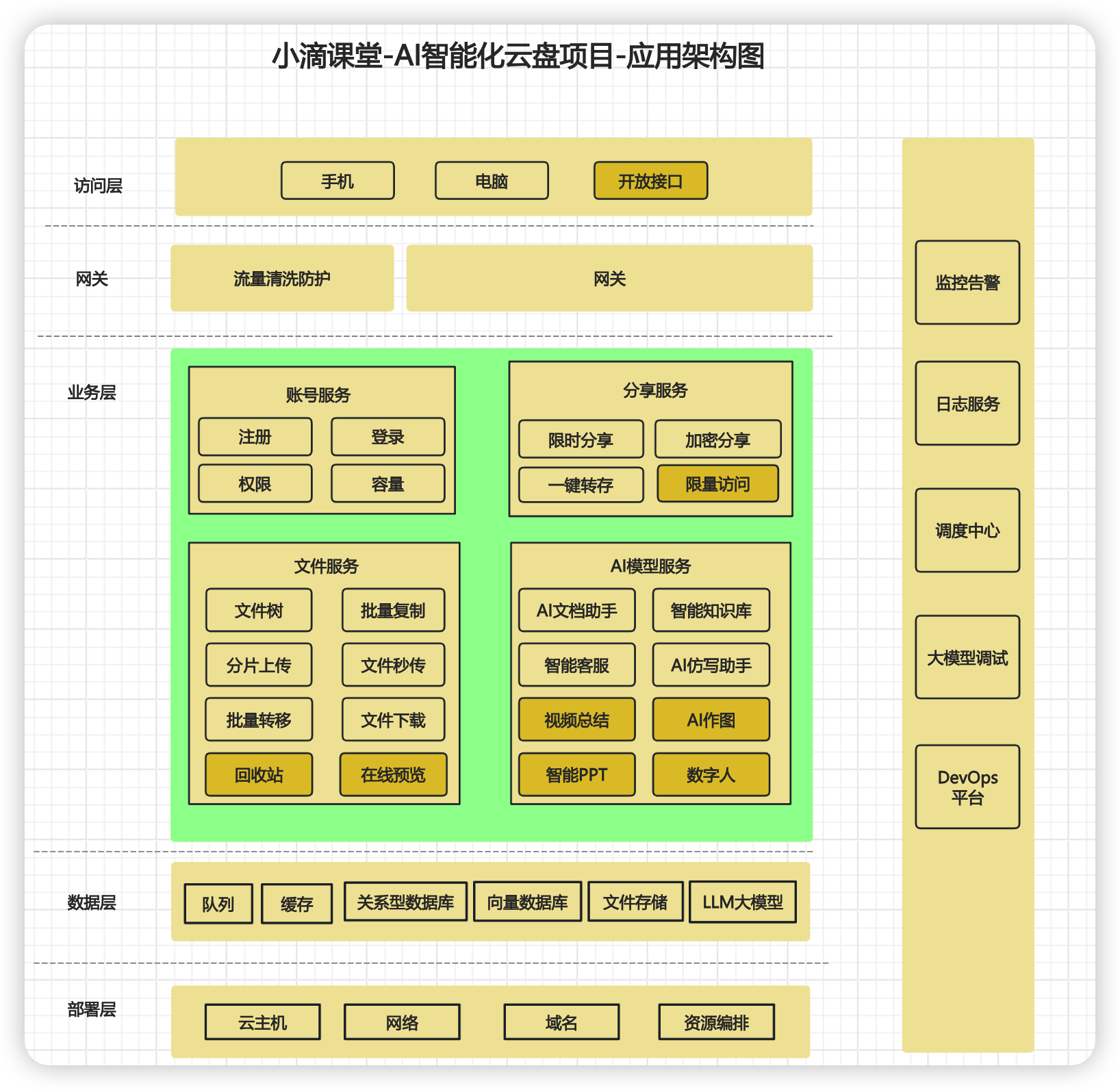

List * 智能云盘

* 智能云盘

* 云盘存储相关设计说明

* 任何文件都有一个唯一标识,我们统一命名为 **identifier**,同个文件产生的标识是不变的

* 唯一标识(identifier)可以采用多个方案,也有对应的类库

* 哈希函数(如MD5、SHA-256)

* 优点:

* 唯一性:理论上 不同的文件内容会产生不同的哈希值,保证了标识的唯一性。

* 快速计算:哈希函数可以快速计算出文件的哈希值。

* 安全性:对于SHA-256等哈希算法,抗碰撞性较强,不易被篡改。

* 缺点:

* 安全性问题:对于MD5,由于其抗碰撞性较弱,已经不推荐用于安全敏感的应用。

* 存储和比较:哈希值需要存储和比较,对于非常大的文件系统,这可能会增加存储和计算开销。

* 基于内容的指纹(如SimHash、Locality-Sensitive Hashing)

* 优点:

* 相似性检测:适用于检测相似或重复的文件,可以容忍文件内容的微小变化。

* 减少存储:通过减少哈希值的位数来减少存储需求。

* 缺点:

* 计算复杂性:相比于简单的哈希函数,这些算法可能需要更复杂的计算。

* 误判率:在某些情况下可能会有误判,即不同的文件产生相同的指纹。

* 文件元数据组合

* 优点:

* 简单易实现:通过文件的大小、创建时间、修改时间等元数据生成标识。

* 快速检索:基于元数据的检索通常很快。

* 缺点:

* 非唯一性:不同的文件可能具有相同的元数据,特别是在文件被复制或修改的情况下。

* 不稳定性:文件的元数据(如修改时间)可能会改变,导致标识失效

* 方案:采用MD5, 相关标识可以前端和后端保持一定规则,前端上传的时候生成标识传递给后端

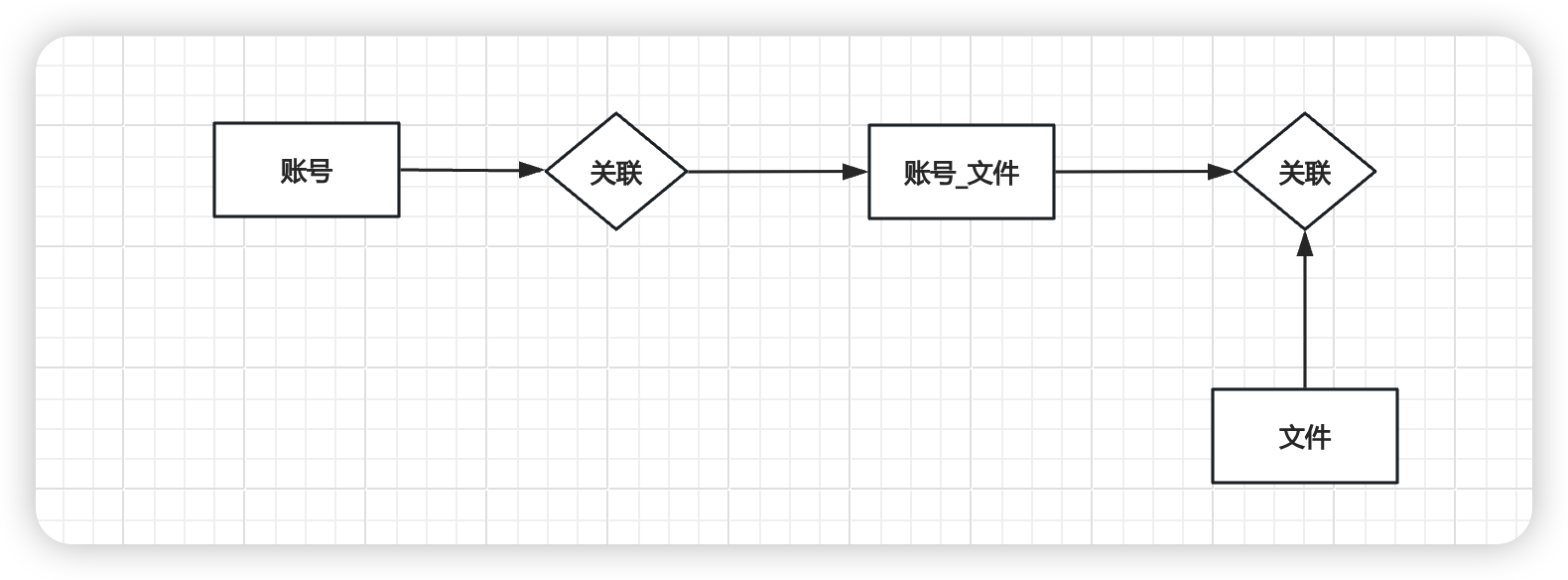

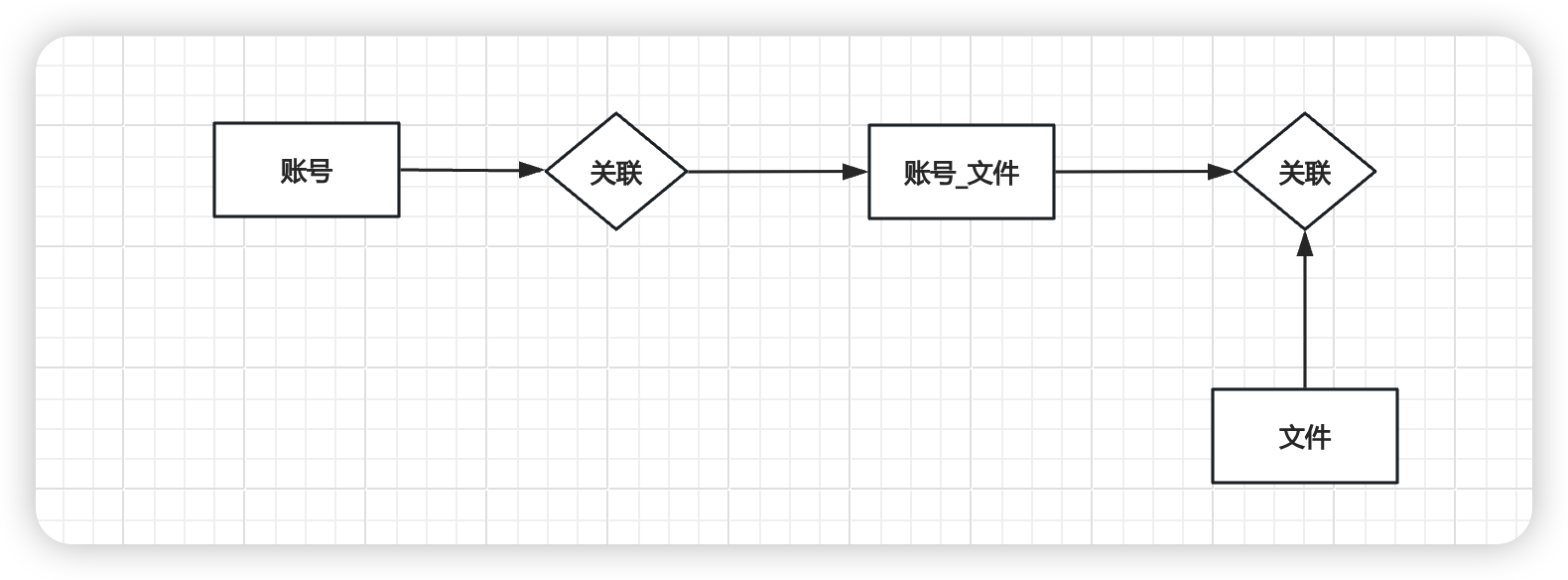

#### 账号表-文件表和关联关系表设计说明

* 三个关键表说明

* **account表**:存储用户的基本信息,如用户名、密码、头像等。这是用户身份验证和个性化设置的基础。

* **file表**:存储文件的元数据,包括文件名、大小、后缀、唯一标识符(MD5)等。主要用于跟踪文件的属性和文件的唯一性

* **account_file表**:

* 存储用户与文件之间的关系,包括文件的层级结构(文件夹和子文件),以及文件的类型和大小等信息。

* 这个表允许一个用户有多个子文件和文件夹,并且可以表示文件的层级关系

* 如果没有`account_file`表,

* 每个用户都重复上传,随着文件数量的增加,没有`account_file`表来组织文件结构,`file`表会变得非常大,性能问题

* 无法有效地表示文件和文件夹的层级结构

* 实现文件的移动、复制、删除等操作会变得复杂,因为没有一个明确的结构来跟踪文件的层级和用户关系

* 权限管理也会变得更加复杂,因为没有一个清晰的结构来定义哪些文件可以被哪些用户访问。

* 智能化云盘设计的3个表理解清楚

* 账号表

* 记录账号相关基础信息

* 关键字段

```

id 即后续用的 account_id

username

password

role 用户角色 COMMON, ADMIN

```

* 账号文件关系表

* 记录对应账号下的文件和文件夹、关系等

* 关键字段

```

id

account_id 账号ID

is_dir 是否是目录,0不是文件夹,1是文件夹

parent_id 上层文件夹ID,顶层文件夹为0

file_id 文件ID,真正存储的文件

file_name 文件名和实际存储的文件名区分开来,可能重命名

```

* 文件表

* 记录文件相关的物理存储信息

```

id 即file_id

account_id 哪个账号上传的

file_name 文件名

object_key 文件的key, 格式 日期/md5.拓展名,比如 2024/11/13/921674fd-cdaf-459a-be7b-109469e7050d.png

identifier 唯一标识,文件MD5

```

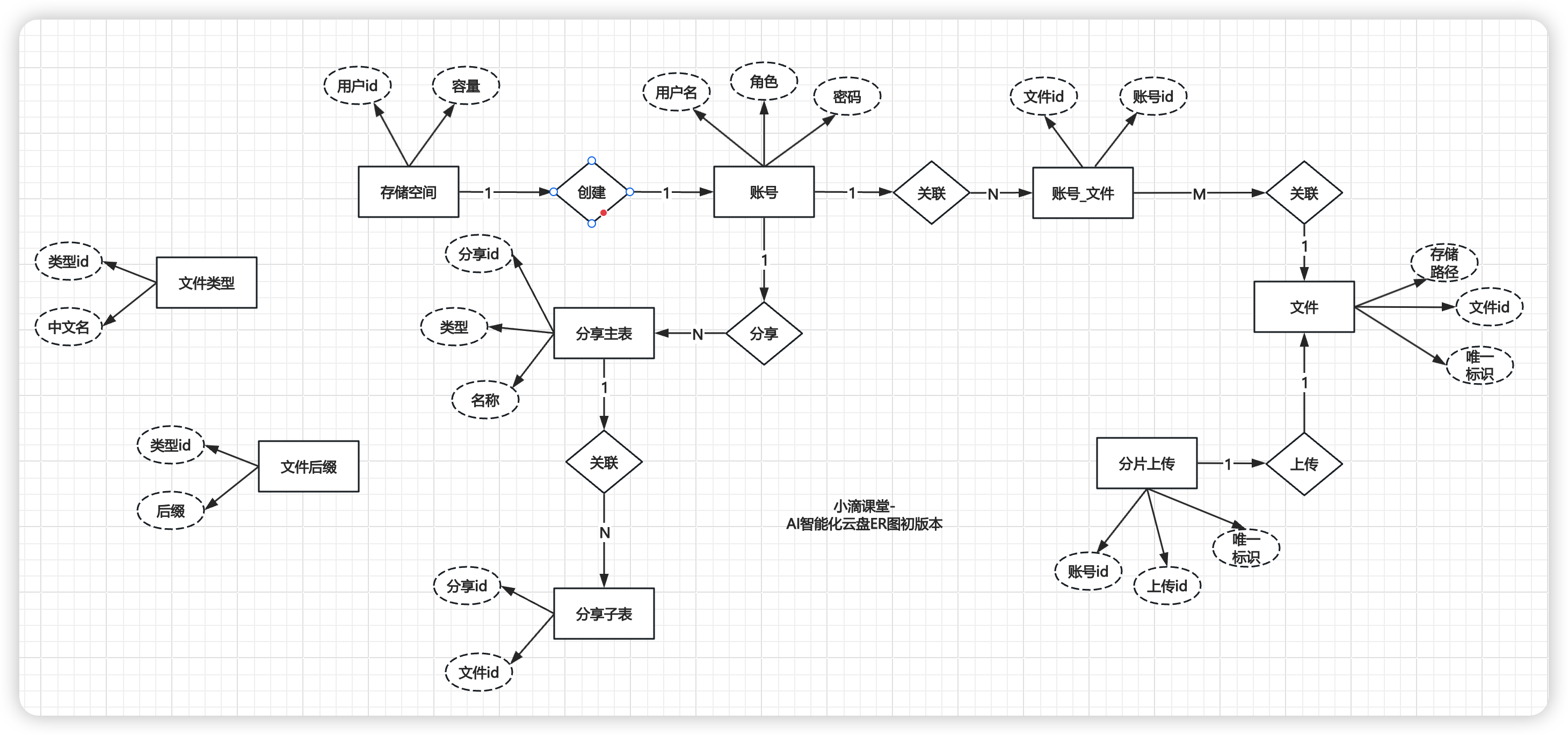

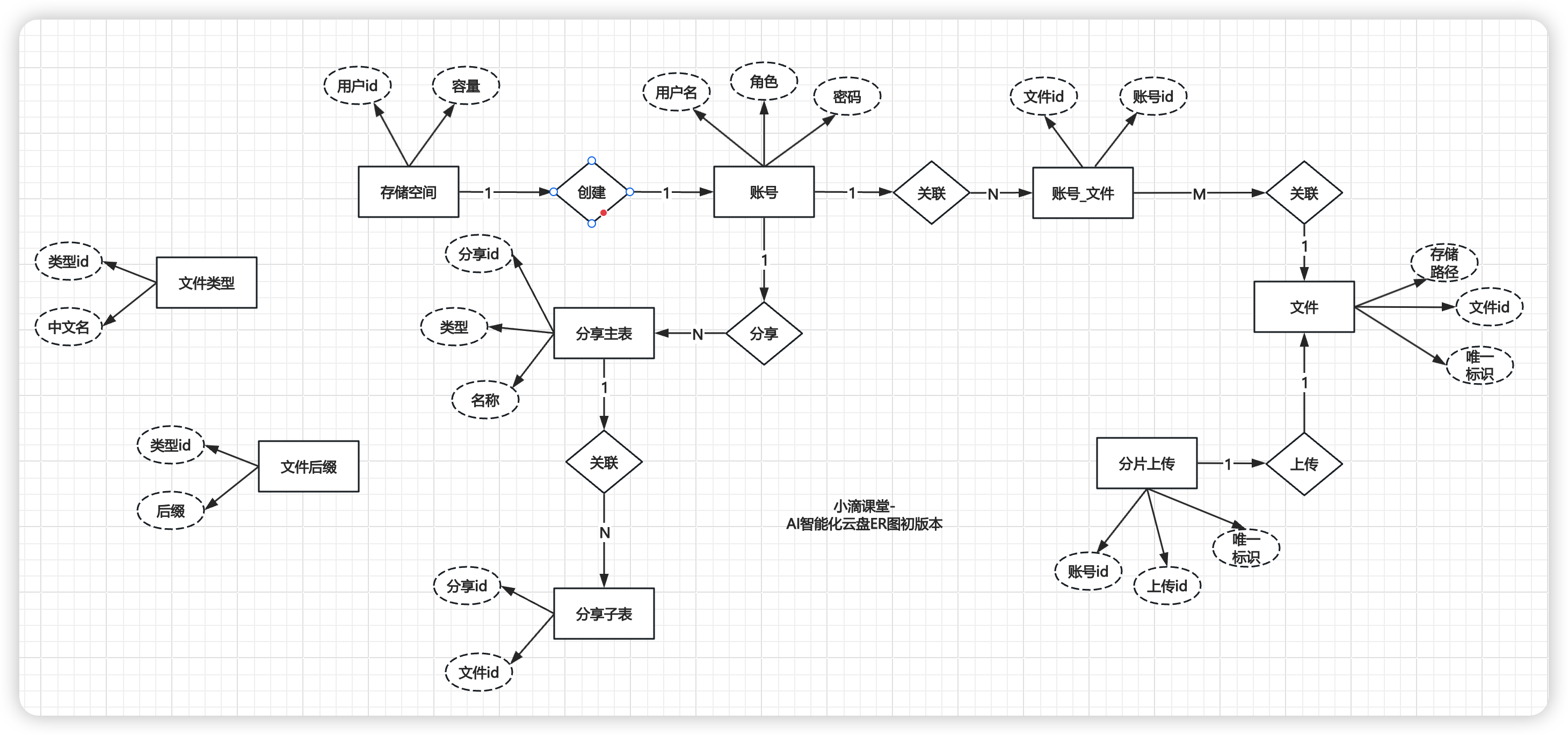

#### AI智能化云盘数据库设计和字段说明

* 数据库ER图设计(**后续还有调整相关表结构**)

* 导入建表语句

#### 智能化云盘数据库逆向工程配置生成

* 配置数据库

```java

public class MyBatisPlusGenerator {

public static void main(String[] args) {

String userName = "root";

String password = "xx";

String serverInfo = "127.0.0.1:3306";

String targetModuleNamePath = "/";

String dbName = "ycloud-aipan";

String[] tables = {

"account", "file","account_file","file_chunk", "file_suffix","file_type", "share", "share_file", "storage"

};

// 使用 FastAutoGenerator 快速配置代码生成器

FastAutoGenerator.create("jdbc:mysql://"+serverInfo+"/"+dbName+"?useUnicode=true&characterEncoding=utf-8&useSSL=false&serverTimezone=Asia/Shanghai&tinyInt1isBit=true", userName, password)

.globalConfig(builder -> {

builder.author("everyone") // 设置作者

.commentDate("yyyy-MM-dd")

.enableSpringdoc()

.disableOpenDir() //禁止打开输出目录

.dateType(DateType.ONLY_DATE) //定义生成的实体类中日期类型 DateType.ONLY_DATE 默认值: DateType.TIME_PACK

.outputDir(System.getProperty("user.dir") + targetModuleNamePath + "/src/main/java"); // 指定输出目录

})

.packageConfig(builder -> {

builder.parent("org.ycloud.aipan") // 父包模块名

.entity("model") //Entity 包名 默认值:entity

.mapper("mapper") //Mapper 包名 默认值:mapper

.pathInfo(Collections.singletonMap(OutputFile.xml, System.getProperty("user.dir") + targetModuleNamePath + "/src/main/resources/mapper")); // 设置mapperXml生成路,默认存放在mapper的xml下

})

.dataSourceConfig(builder -> {//Mysql下tinyint字段转换

builder.typeConvertHandler((globalConfig, typeRegistry, metaInfo) -> {

if (JdbcType.TINYINT == metaInfo.getJdbcType()) {

return DbColumnType.BOOLEAN;

}

return typeRegistry.getColumnType(metaInfo);

});

})

.strategyConfig(builder -> {

builder.addInclude(tables) // 设置需要生成的表名 可变参数

.entityBuilder()// Entity策略配置

.enableFileOverride() // 开启生成Entity层文件覆盖

.idType(IdType.ASSIGN_ID)//主键策略 雪花算法自动生成的id

.enableLombok() //开启lombok

.logicDeleteColumnName("del")// 说明逻辑删除是哪个字段

.enableTableFieldAnnotation()// 属性加上注解说明

.formatFileName("%sDO") //格式化生成的文件名称

.controllerBuilder().disable()// Controller策略配置,这里不生成Controller层

.serviceBuilder().disable()// Service策略配置,这里不生成Service层

.mapperBuilder()// Mapper策略配置

.enableFileOverride() // 开启生成Mapper层文件覆盖

.formatMapperFileName("%sMapper")// 格式化Mapper文件名称

.superClass(BaseMapper.class) //继承的父类

.enableBaseResultMap() // 开启生成resultMap,

.enableBaseColumnList() // 开启生成Sql片段

.formatXmlFileName("%sMapper"); // 格式化xml文件名称

})

.templateConfig(builder -> {

// 不生成Controller

builder.disable(TemplateType.CONTROLLER,TemplateType.SERVICE,TemplateType.SERVICE_IMPL);

})

.execute(); // 执行生成

}

}

```

### 账号模块开发和Knife4j接口文档配置

#### Knife4j接口文档工具

* 什么是Knife4j

* 一个为Java MVC框架集成Swagger生成Api文档的增强解决方案,前身是swagger-bootstrap-ui。

* 提供了新的Web页面,更符合使用习惯和审美;补充了一些注解,扩展了原生Swagger的功能;

* 是一个更小巧、轻量且功能强悍的接口文档管理工具

* 核心功能

* **文档说明**:详细列出接口文档的说明,包括接口地址、类型、请求示例、请求参数、响应示例、响应参数、响应码等信息。

* **在线调试**:提供在线接口联调功能,自动解析当前接口参数,返回接口响应内容、headers、响应时间、响应状态码等信息。

* **接口搜索**:提供强大的接口搜索功能,支持按接口地址、请求方法、接口描述等关键字进行搜索。

* **接口过滤**:提供接口过滤功能,可以根据接口分组、接口标签、接口地址等条件进行过滤。

* **自定义主题**:支持自定义主题,定制个性化的API文档界面。

* **丰富的扩展功能**:如接口排序、接口分组、接口标签等,进一步丰富了API文档管理的功能。

* 配置实战

* 添加依赖

```xml

* 云盘存储相关设计说明

* 任何文件都有一个唯一标识,我们统一命名为 **identifier**,同个文件产生的标识是不变的

* 唯一标识(identifier)可以采用多个方案,也有对应的类库

* 哈希函数(如MD5、SHA-256)

* 优点:

* 唯一性:理论上 不同的文件内容会产生不同的哈希值,保证了标识的唯一性。

* 快速计算:哈希函数可以快速计算出文件的哈希值。

* 安全性:对于SHA-256等哈希算法,抗碰撞性较强,不易被篡改。

* 缺点:

* 安全性问题:对于MD5,由于其抗碰撞性较弱,已经不推荐用于安全敏感的应用。

* 存储和比较:哈希值需要存储和比较,对于非常大的文件系统,这可能会增加存储和计算开销。

* 基于内容的指纹(如SimHash、Locality-Sensitive Hashing)

* 优点:

* 相似性检测:适用于检测相似或重复的文件,可以容忍文件内容的微小变化。

* 减少存储:通过减少哈希值的位数来减少存储需求。

* 缺点:

* 计算复杂性:相比于简单的哈希函数,这些算法可能需要更复杂的计算。

* 误判率:在某些情况下可能会有误判,即不同的文件产生相同的指纹。

* 文件元数据组合

* 优点:

* 简单易实现:通过文件的大小、创建时间、修改时间等元数据生成标识。

* 快速检索:基于元数据的检索通常很快。

* 缺点:

* 非唯一性:不同的文件可能具有相同的元数据,特别是在文件被复制或修改的情况下。

* 不稳定性:文件的元数据(如修改时间)可能会改变,导致标识失效

* 方案:采用MD5, 相关标识可以前端和后端保持一定规则,前端上传的时候生成标识传递给后端

#### 账号表-文件表和关联关系表设计说明

* 三个关键表说明

* **account表**:存储用户的基本信息,如用户名、密码、头像等。这是用户身份验证和个性化设置的基础。

* **file表**:存储文件的元数据,包括文件名、大小、后缀、唯一标识符(MD5)等。主要用于跟踪文件的属性和文件的唯一性

* **account_file表**:

* 存储用户与文件之间的关系,包括文件的层级结构(文件夹和子文件),以及文件的类型和大小等信息。

* 这个表允许一个用户有多个子文件和文件夹,并且可以表示文件的层级关系

* 如果没有`account_file`表,

* 每个用户都重复上传,随着文件数量的增加,没有`account_file`表来组织文件结构,`file`表会变得非常大,性能问题

* 无法有效地表示文件和文件夹的层级结构

* 实现文件的移动、复制、删除等操作会变得复杂,因为没有一个明确的结构来跟踪文件的层级和用户关系

* 权限管理也会变得更加复杂,因为没有一个清晰的结构来定义哪些文件可以被哪些用户访问。

* 智能化云盘设计的3个表理解清楚

* 账号表

* 记录账号相关基础信息

* 关键字段

```

id 即后续用的 account_id

username

password

role 用户角色 COMMON, ADMIN

```

* 账号文件关系表

* 记录对应账号下的文件和文件夹、关系等

* 关键字段

```

id

account_id 账号ID

is_dir 是否是目录,0不是文件夹,1是文件夹

parent_id 上层文件夹ID,顶层文件夹为0

file_id 文件ID,真正存储的文件

file_name 文件名和实际存储的文件名区分开来,可能重命名

```

* 文件表

* 记录文件相关的物理存储信息

```

id 即file_id

account_id 哪个账号上传的

file_name 文件名

object_key 文件的key, 格式 日期/md5.拓展名,比如 2024/11/13/921674fd-cdaf-459a-be7b-109469e7050d.png

identifier 唯一标识,文件MD5

```

#### AI智能化云盘数据库设计和字段说明

* 数据库ER图设计(**后续还有调整相关表结构**)

* 导入建表语句

#### 智能化云盘数据库逆向工程配置生成

* 配置数据库

```java

public class MyBatisPlusGenerator {

public static void main(String[] args) {

String userName = "root";

String password = "xx";

String serverInfo = "127.0.0.1:3306";

String targetModuleNamePath = "/";

String dbName = "ycloud-aipan";

String[] tables = {

"account", "file","account_file","file_chunk", "file_suffix","file_type", "share", "share_file", "storage"

};

// 使用 FastAutoGenerator 快速配置代码生成器

FastAutoGenerator.create("jdbc:mysql://"+serverInfo+"/"+dbName+"?useUnicode=true&characterEncoding=utf-8&useSSL=false&serverTimezone=Asia/Shanghai&tinyInt1isBit=true", userName, password)

.globalConfig(builder -> {

builder.author("everyone") // 设置作者

.commentDate("yyyy-MM-dd")

.enableSpringdoc()

.disableOpenDir() //禁止打开输出目录

.dateType(DateType.ONLY_DATE) //定义生成的实体类中日期类型 DateType.ONLY_DATE 默认值: DateType.TIME_PACK

.outputDir(System.getProperty("user.dir") + targetModuleNamePath + "/src/main/java"); // 指定输出目录

})

.packageConfig(builder -> {

builder.parent("org.ycloud.aipan") // 父包模块名

.entity("model") //Entity 包名 默认值:entity

.mapper("mapper") //Mapper 包名 默认值:mapper

.pathInfo(Collections.singletonMap(OutputFile.xml, System.getProperty("user.dir") + targetModuleNamePath + "/src/main/resources/mapper")); // 设置mapperXml生成路,默认存放在mapper的xml下

})

.dataSourceConfig(builder -> {//Mysql下tinyint字段转换

builder.typeConvertHandler((globalConfig, typeRegistry, metaInfo) -> {

if (JdbcType.TINYINT == metaInfo.getJdbcType()) {

return DbColumnType.BOOLEAN;

}

return typeRegistry.getColumnType(metaInfo);

});

})

.strategyConfig(builder -> {

builder.addInclude(tables) // 设置需要生成的表名 可变参数

.entityBuilder()// Entity策略配置

.enableFileOverride() // 开启生成Entity层文件覆盖

.idType(IdType.ASSIGN_ID)//主键策略 雪花算法自动生成的id

.enableLombok() //开启lombok

.logicDeleteColumnName("del")// 说明逻辑删除是哪个字段

.enableTableFieldAnnotation()// 属性加上注解说明

.formatFileName("%sDO") //格式化生成的文件名称

.controllerBuilder().disable()// Controller策略配置,这里不生成Controller层

.serviceBuilder().disable()// Service策略配置,这里不生成Service层

.mapperBuilder()// Mapper策略配置

.enableFileOverride() // 开启生成Mapper层文件覆盖

.formatMapperFileName("%sMapper")// 格式化Mapper文件名称

.superClass(BaseMapper.class) //继承的父类

.enableBaseResultMap() // 开启生成resultMap,

.enableBaseColumnList() // 开启生成Sql片段

.formatXmlFileName("%sMapper"); // 格式化xml文件名称

})

.templateConfig(builder -> {

// 不生成Controller

builder.disable(TemplateType.CONTROLLER,TemplateType.SERVICE,TemplateType.SERVICE_IMPL);

})

.execute(); // 执行生成

}

}

```

### 账号模块开发和Knife4j接口文档配置

#### Knife4j接口文档工具

* 什么是Knife4j

* 一个为Java MVC框架集成Swagger生成Api文档的增强解决方案,前身是swagger-bootstrap-ui。

* 提供了新的Web页面,更符合使用习惯和审美;补充了一些注解,扩展了原生Swagger的功能;

* 是一个更小巧、轻量且功能强悍的接口文档管理工具

* 核心功能

* **文档说明**:详细列出接口文档的说明,包括接口地址、类型、请求示例、请求参数、响应示例、响应参数、响应码等信息。

* **在线调试**:提供在线接口联调功能,自动解析当前接口参数,返回接口响应内容、headers、响应时间、响应状态码等信息。

* **接口搜索**:提供强大的接口搜索功能,支持按接口地址、请求方法、接口描述等关键字进行搜索。

* **接口过滤**:提供接口过滤功能,可以根据接口分组、接口标签、接口地址等条件进行过滤。

* **自定义主题**:支持自定义主题,定制个性化的API文档界面。

* **丰富的扩展功能**:如接口排序、接口分组、接口标签等,进一步丰富了API文档管理的功能。

* 配置实战

* 添加依赖

```xml

* knife4j 访问地址:http://localhost:8080/doc.html

* Swagger2.0访问地址:http://localhost:8080/swagger-ui.html

* Swagger3.0访问地址:http://localhost:8080/swagger-ui/index.html

*/

@Slf4j

@Configuration

public class Knife4jConfig {

@Bean

public OpenAPI customOpenAPI() {

return new OpenAPI()

.info(new Info()

.title("AI智能云盘系统 API")

.version("1.0-SNAPSHOT")

.description("AI智能云盘系统")

.termsOfService("https://www.xxx.net")

.license(new License().name("Apache 2.0").url("https://www.xxx.net"))

// 添加作者信息

.contact(new Contact()

.name("anonymity") // 替换为作者的名字

.email("anonymity@qq.com") // 替换为作者的电子邮件

.url("https://www.xxx.net") // 替换为作者的网站或个人资料链接

)

);

}

}

```

* 配置Spring Boot控制台打印

```java

@Slf4j

@SpringBootApplication

public class CloudApplication {

public static void main(String[] args) throws Exception {

ConfigurableApplicationContext application = SpringApplication.run(CloudApplication.class, args);

Environment env = application.getEnvironment();

log.info("\n----------------------------------------------------------\n\t" +

"Application '{}' is running! Access URLs:\n\t" +

"Local: \t\thttp://localhost:{}\n\t" +

"External: \thttp://{}:{}\n\t" +

"API文档: \thttp://{}:{}/doc.html\n" +

"----------------------------------------------------------",

env.getProperty("spring.application.name"),

env.getProperty("server.port"),

InetAddress.getLocalHost().getHostAddress(),

env.getProperty("server.port"),

InetAddress.getLocalHost().getHostAddress(),

env.getProperty("server.port"));

}

}

```

#### 账号注册相关模块接口开发实战

* 需求

* 开发用户注册相关接口,手机号注册

* 内部使用, 不加验证码,如果需要对外则可以加入验证码逻辑

* 用户板块不做复杂权限或者多重校验处理等

* 逻辑说明

* 根据手机号查询是否重复(或者唯一索引)

* 密码加密处理

* 保存用户注册逻辑

* 其他逻辑(创建默认的存储空间,初始化根目录)

* 编码实战:

> 编写`AccountController,AccountRegisterReq,AccountService,AccountConfig`...

```sql

CREATE TABLE `account` (

`id` bigint NOT NULL COMMENT 'ID',

`username` varchar(255) CHARACTER SET utf8mb4 COLLATE utf8mb4_general_ci NOT NULL COMMENT '用户名',

`password` varchar(255) CHARACTER SET utf8mb4 COLLATE utf8mb4_general_ci NOT NULL COMMENT '密码',

`avatar_url` varchar(255) CHARACTER SET utf8mb4 COLLATE utf8mb4_general_ci DEFAULT NULL COMMENT '用户头像',

`phone` varchar(255) CHARACTER SET utf8mb4 COLLATE utf8mb4_general_ci DEFAULT NULL COMMENT '手机号',

`role` varchar(255) CHARACTER SET utf8mb4 COLLATE utf8mb4_general_ci DEFAULT 'COMMON' COMMENT '用户角色 COMMON, ADMIN',

`del` tinyint DEFAULT '0' COMMENT '逻辑删除(1删除 0未删除)',

`gmt_create` datetime NOT NULL DEFAULT CURRENT_TIMESTAMP COMMENT '创建时间',

`gmt_modified` datetime NOT NULL DEFAULT CURRENT_TIMESTAMP ON UPDATE CURRENT_TIMESTAMP COMMENT '更新时间',

PRIMARY KEY (`id`) USING BTREE,

UNIQUE KEY `idx_phone_uni` (`phone`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4 COLLATE=utf8mb4_general_ci ROW_FORMAT=DYNAMIC COMMENT='用户信息表';

```

#### 头像上传接口开发和MinIO权限配置

* 需求

* 开发头像上传接口,用户注册时候需要把头像url进行上传

* **存储到minio需要可以公开访问,和文件存储分开bucket**

* 逻辑说明

* 文件上传接口

* 返回文件访问路径

* **配置minio的头像存储bucket存储权限为public**

#### 网盘存储容量设计和根目录初始化配置

* 需求

* **问题一:新用户注册,有默认网盘存储容量,什么时候进行初始化?**

* 答案

* 用户注册的时候一并配置相关的初始化内容

* 如果是简单场景:直接调用; 复杂场景:结合消息队列

* 类似场景大家可以思考下还有哪些,各大公司拉新活动折扣

* 1、检查父文件ID是否存在,避免越权

* 2、检查文件名是否重复

* 3、保存文件信息

*

* @return

*/

private Long saveAccountFile(AccountFileDTO accountFileDTO) {

//检查父文件ID是否存在

checkParentFileId(accountFileDTO);

//存储文件信息

AccountFileDO accountFileDO = SpringBeanUtil.copyProperties(accountFileDTO, AccountFileDO.class);

//检查文件名是否重复

processFileNameDuplicate(accountFileDO);

accountFileMapper.insert(accountFileDO);

return accountFileDO.getId();

}

```

#### 网盘文件重命名相关接口

* 需求

* 开发网盘文件重命名接口,包括文件夹和文件一样适用

* **问题二:网盘文件存储有个根目录,这个如何进行设计?**

* 上传文件的到根目录,这个相关的parent_id是怎么填写?

* 答案:参考Linux操作系统,根目录也是一个目录

* 开发编码实战:创建文件夹

```java

//3.创建默认的存储空间

StorageDO storageDO = new StorageDO();

storageDO.setAccountId(accountDO.getId());

storageDO.setUsedSize(0L);

storageDO.setTotalSize(AccountConfig.DEFAULT_STORAGE_SIZE);

storageMapper.insert(storageDO);

//4.初始化根目录

FolderCreateReq createRootFolderReq = FolderCreateReq.builder()

.accountId(accountDO.getId())

.parentId(AccountConfig.ROOT_PARENT_ID)

.folderName(AccountConfig.ROOT_FOLDER_NAME)

.build();

accountFileService.createFolder(createRootFolderReq);

```

#### 账号登录相关模块设计和开发实战

* 需求

* 开发用户登录模块

* 配置生成JWT

* 编码实战

```java

//业务逻辑

public AccountDTO login(AccountLoginReq req) {

String encryptPassword = DigestUtils.md5DigestAsHex(( AccountConfig.ACCOUNT_SALT+ req.getPassword()).getBytes());

QueryWrapper

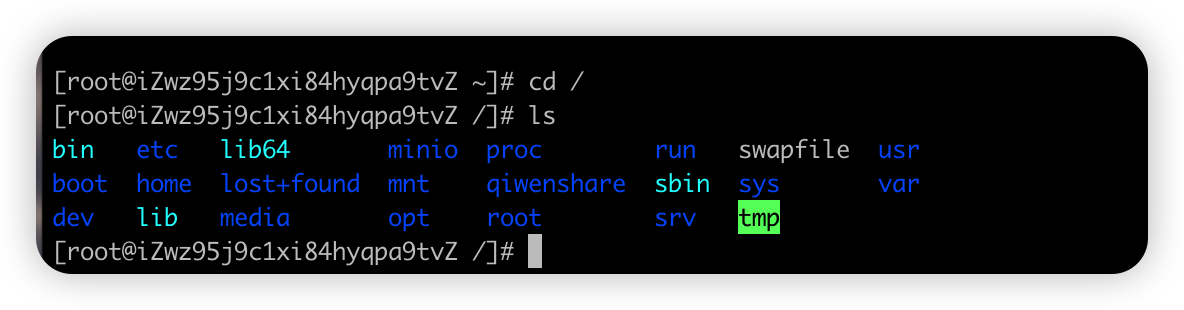

* **问题二:网盘文件存储有个根目录,这个如何进行设计?**

* 上传文件的到根目录,这个相关的parent_id是怎么填写?

* 答案:参考Linux操作系统,根目录也是一个目录

* 开发编码实战:创建文件夹

```java

//3.创建默认的存储空间

StorageDO storageDO = new StorageDO();

storageDO.setAccountId(accountDO.getId());

storageDO.setUsedSize(0L);

storageDO.setTotalSize(AccountConfig.DEFAULT_STORAGE_SIZE);

storageMapper.insert(storageDO);

//4.初始化根目录

FolderCreateReq createRootFolderReq = FolderCreateReq.builder()

.accountId(accountDO.getId())

.parentId(AccountConfig.ROOT_PARENT_ID)

.folderName(AccountConfig.ROOT_FOLDER_NAME)

.build();

accountFileService.createFolder(createRootFolderReq);

```

#### 账号登录相关模块设计和开发实战

* 需求

* 开发用户登录模块

* 配置生成JWT

* 编码实战

```java

//业务逻辑

public AccountDTO login(AccountLoginReq req) {

String encryptPassword = DigestUtils.md5DigestAsHex(( AccountConfig.ACCOUNT_SALT+ req.getPassword()).getBytes());

QueryWrapper * 逻辑说明

* 步骤一

* 进入首页需要先获取用户的根目录文件夹ID

* 通过根目录文件夹ID去获取对应的文件列表

* 步骤二

* 首页需要显示用户的存储空间

* 编码实战

```java

public AccountDTO queryDetail(Long accountId) {

//账号详情

AccountDO accountDO = accountMapper.selectById(accountId);

AccountDTO accountDTO = SpringBeanUtil.copyProperties(accountDO, AccountDTO.class);

//存储信息

StorageDO storageDO = storageMapper.selectOne(new QueryWrapper

* 逻辑说明

* 步骤一

* 进入首页需要先获取用户的根目录文件夹ID

* 通过根目录文件夹ID去获取对应的文件列表

* 步骤二

* 首页需要显示用户的存储空间

* 编码实战

```java

public AccountDTO queryDetail(Long accountId) {

//账号详情

AccountDO accountDO = accountMapper.selectById(accountId);

AccountDTO accountDTO = SpringBeanUtil.copyProperties(accountDO, AccountDTO.class);

//存储信息

StorageDO storageDO = storageMapper.selectOne(new QueryWrapper AI补充接口文档和注释字段操作

* AI补充API接口文档

* `补充knife4j的接口文档配置内容,@Tag @Operation等注解,使用v3`

* AI补充字段解释说明

* `补充knife4j接口文档信息,使用@Schema,使用v3,添加参数举例`

### 网盘文件模块基础设计和开发

#### 资源访问安全之web常见越权攻击和防范

* **越权攻击介绍**

* 是Web应用程序中一种常见的漏洞,由于其存在范围广、危害 大, 列为Web应用十大安全隐患的第二名

* 指应用在检查授权时存在纰漏,使得攻击者在获得低权限用户账户后,利用一些方式绕过权限检查,访问或者操作其他用户

* 产生原因:主要是因为开发人员在对数据进行增、删、改、查询时对客户端请求的数据过分相信,而遗漏了权限的判定

* 比如网盘里面:分享、转存、查看文件的时候都容易触发

* **水平越权攻击**

- 指的是攻击者通过某种手段获取了与自己权限相同的其他账户的访问权限。

- 用户A能够访问用户B的账户信息,尽管他们都是普通用户,但A不应该能够访问B的数据。

- 技术实现方式

- **参数篡改**:

- 攻击者通过修改请求中的用户ID参数,尝试访问其他同级别用户的资源。

- 在电商系统中,用户A通过修改订单ID参数,尝试查看或修改用户B的订单信息。

- **会话劫持**:

- 攻击者通过某种方式获取了其他用户的会话信息,从而冒充该用户进行操作,这可能导致水平越权问题。

- **利用前端安全漏洞**:

- 如果前端安全措施不当,攻击者可能会通过修改前端显示的界面元素,如隐藏的URL或参数,来访问其他用户的数据。

* **水平越权攻击的防范**:

- **权限验证**:确保每次数据访问都进行严格的权限验证。

- **数据隔离**:不同用户的数据应该在数据库层面进行隔离。

- **会话管理**:使用安全的会话管理机制,如HTTPS、Token等。

* **垂直越权攻击**

- 指的是攻击者通过某种手段获取了更高权限的账户的访问权限。

- 普通用户获取了管理员账户或者更高的权限。

- 技术实现方式

- **权限配置错误**:

- 由于系统配置不当,普通用户能够执行管理员级别的操作,例如通过修改请求中的权限参数来提升权限。

- **利用系统漏洞**:

- 攻击者利用系统或应用程序的漏洞提升权限,例如通过SQL注入攻击来执行管理员级别的数据库操作。

- **多阶段功能滥用**:

- 在多阶段功能实现中,如果后续阶段不再验证用户身份,攻击者可能通过抓包修改参数值,实现越权操作,如修改任意用户密码

- **垂直越权攻击的防范**:

- **最小权限原则**:用户和系统组件应该只拥有完成其任务所必需的最小权限。

- **权限审查**:定期审查权限设置,确保没有不必要的权限提升。

- **安全编码**:遵循安全编码实践,避免常见的安全漏洞,如SQL注入、跨站脚本(XSS)等。

- **安全审计**:实施安全审计,监控和记录关键操作,以便在发生安全事件时进行追踪。

* 智能化网盘项目里面的避免越权处理方案

* 相关文件数据处理,加入account_id确认

* 角色权限通过role进行确认操作

#### 文件模块开发之查询文件列表接口开发

* 需求

* 网盘存储首页进入,会触发哪些请求?**获取当前用户根目录文件夹**

* 根据根目录文件夹查询对应的文件列表

* 进入相关的指定文件夹,查询对应的子文件

AI补充接口文档和注释字段操作

* AI补充API接口文档

* `补充knife4j的接口文档配置内容,@Tag @Operation等注解,使用v3`

* AI补充字段解释说明

* `补充knife4j接口文档信息,使用@Schema,使用v3,添加参数举例`

### 网盘文件模块基础设计和开发

#### 资源访问安全之web常见越权攻击和防范

* **越权攻击介绍**

* 是Web应用程序中一种常见的漏洞,由于其存在范围广、危害 大, 列为Web应用十大安全隐患的第二名

* 指应用在检查授权时存在纰漏,使得攻击者在获得低权限用户账户后,利用一些方式绕过权限检查,访问或者操作其他用户

* 产生原因:主要是因为开发人员在对数据进行增、删、改、查询时对客户端请求的数据过分相信,而遗漏了权限的判定

* 比如网盘里面:分享、转存、查看文件的时候都容易触发

* **水平越权攻击**

- 指的是攻击者通过某种手段获取了与自己权限相同的其他账户的访问权限。

- 用户A能够访问用户B的账户信息,尽管他们都是普通用户,但A不应该能够访问B的数据。

- 技术实现方式

- **参数篡改**:

- 攻击者通过修改请求中的用户ID参数,尝试访问其他同级别用户的资源。

- 在电商系统中,用户A通过修改订单ID参数,尝试查看或修改用户B的订单信息。

- **会话劫持**:

- 攻击者通过某种方式获取了其他用户的会话信息,从而冒充该用户进行操作,这可能导致水平越权问题。

- **利用前端安全漏洞**:

- 如果前端安全措施不当,攻击者可能会通过修改前端显示的界面元素,如隐藏的URL或参数,来访问其他用户的数据。

* **水平越权攻击的防范**:

- **权限验证**:确保每次数据访问都进行严格的权限验证。

- **数据隔离**:不同用户的数据应该在数据库层面进行隔离。

- **会话管理**:使用安全的会话管理机制,如HTTPS、Token等。

* **垂直越权攻击**

- 指的是攻击者通过某种手段获取了更高权限的账户的访问权限。

- 普通用户获取了管理员账户或者更高的权限。

- 技术实现方式

- **权限配置错误**:

- 由于系统配置不当,普通用户能够执行管理员级别的操作,例如通过修改请求中的权限参数来提升权限。

- **利用系统漏洞**:

- 攻击者利用系统或应用程序的漏洞提升权限,例如通过SQL注入攻击来执行管理员级别的数据库操作。

- **多阶段功能滥用**:

- 在多阶段功能实现中,如果后续阶段不再验证用户身份,攻击者可能通过抓包修改参数值,实现越权操作,如修改任意用户密码

- **垂直越权攻击的防范**:

- **最小权限原则**:用户和系统组件应该只拥有完成其任务所必需的最小权限。

- **权限审查**:定期审查权限设置,确保没有不必要的权限提升。

- **安全编码**:遵循安全编码实践,避免常见的安全漏洞,如SQL注入、跨站脚本(XSS)等。

- **安全审计**:实施安全审计,监控和记录关键操作,以便在发生安全事件时进行追踪。

* 智能化网盘项目里面的避免越权处理方案

* 相关文件数据处理,加入account_id确认

* 角色权限通过role进行确认操作

#### 文件模块开发之查询文件列表接口开发

* 需求

* 网盘存储首页进入,会触发哪些请求?**获取当前用户根目录文件夹**

* 根据根目录文件夹查询对应的文件列表

* 进入相关的指定文件夹,查询对应的子文件

* 注意事项

* 查询的时候都需要加入账号相关进行确认

**前面代码相对会简单点,逐步代码封装和抽取就会上升难度,**

* 编码实战

```java

@GetMapping("list")

public JsonData list(@RequestParam(value = "parent_id")Long parentId){

Long accountId = LoginInterceptor.threadLocal.get().getId();

List

* 注意事项

* 查询的时候都需要加入账号相关进行确认

**前面代码相对会简单点,逐步代码封装和抽取就会上升难度,**

* 编码实战

```java

@GetMapping("list")

public JsonData list(@RequestParam(value = "parent_id")Long parentId){

Long accountId = LoginInterceptor.threadLocal.get().getId();

List * 业务逻辑方法梳理

* 文件ID是否存在,避免越权

* 新旧文件名称不能一样

* 也不能用同层文件夹的名称,通过parent_id进行查询

* 编码实战

```java

@Override

public void renameFile(FileUpdateReq req) {

//文件ID是否存在,避免越权

AccountFileDO accountFileDO = accountFileMapper.selectOne(new QueryWrapper

* 业务逻辑方法梳理

* 文件ID是否存在,避免越权

* 新旧文件名称不能一样

* 也不能用同层文件夹的名称,通过parent_id进行查询

* 编码实战

```java

@Override

public void renameFile(FileUpdateReq req) {

//文件ID是否存在,避免越权

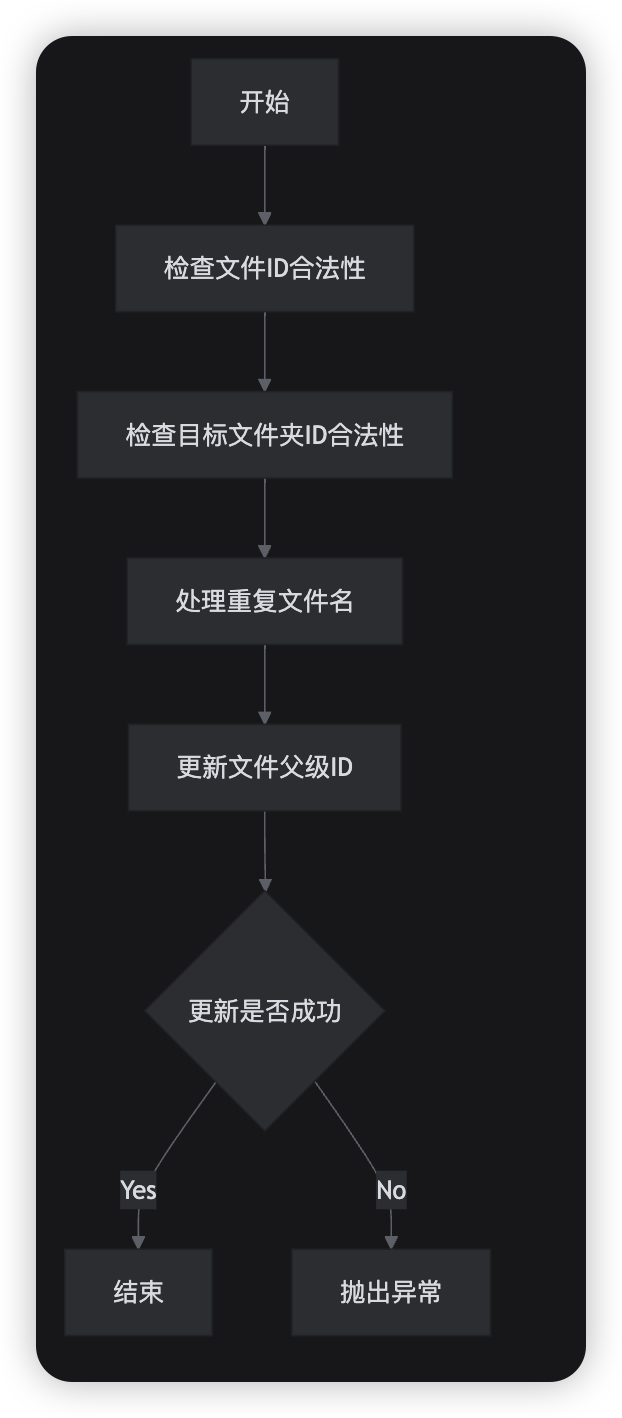

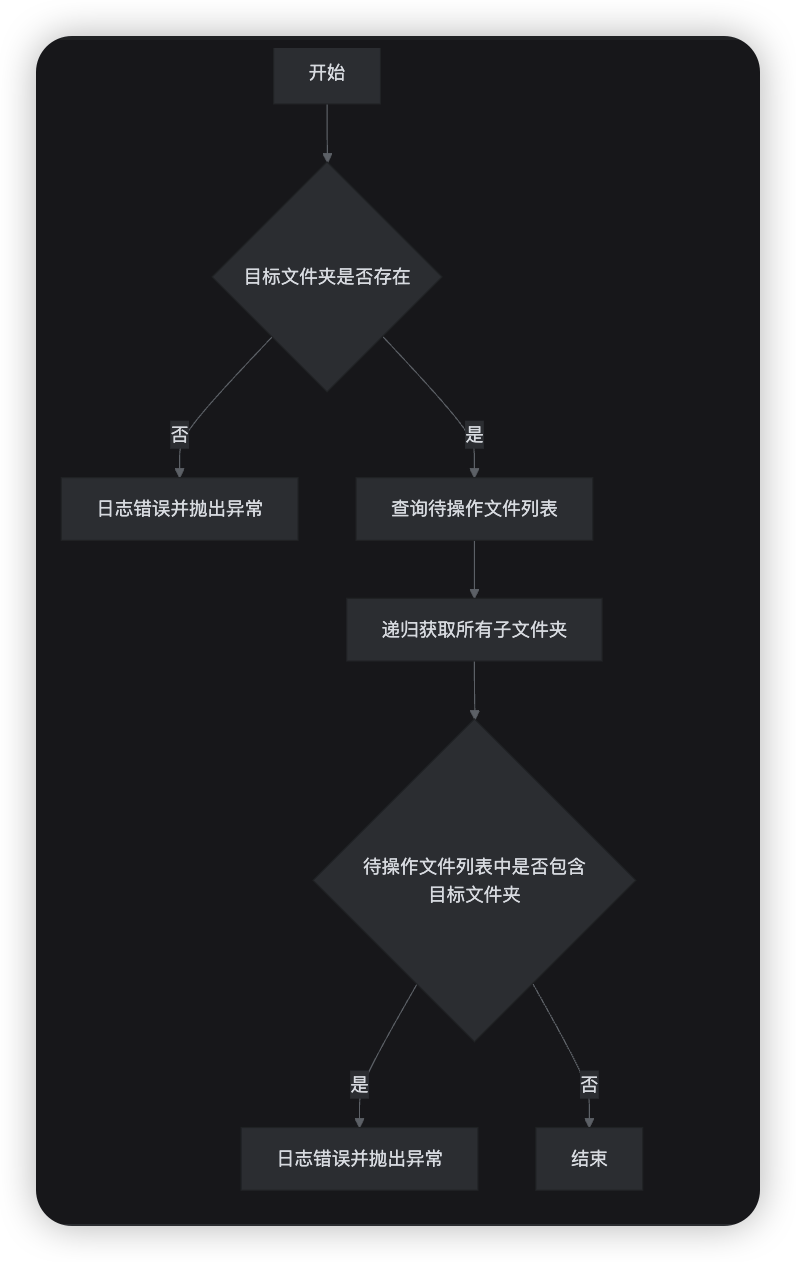

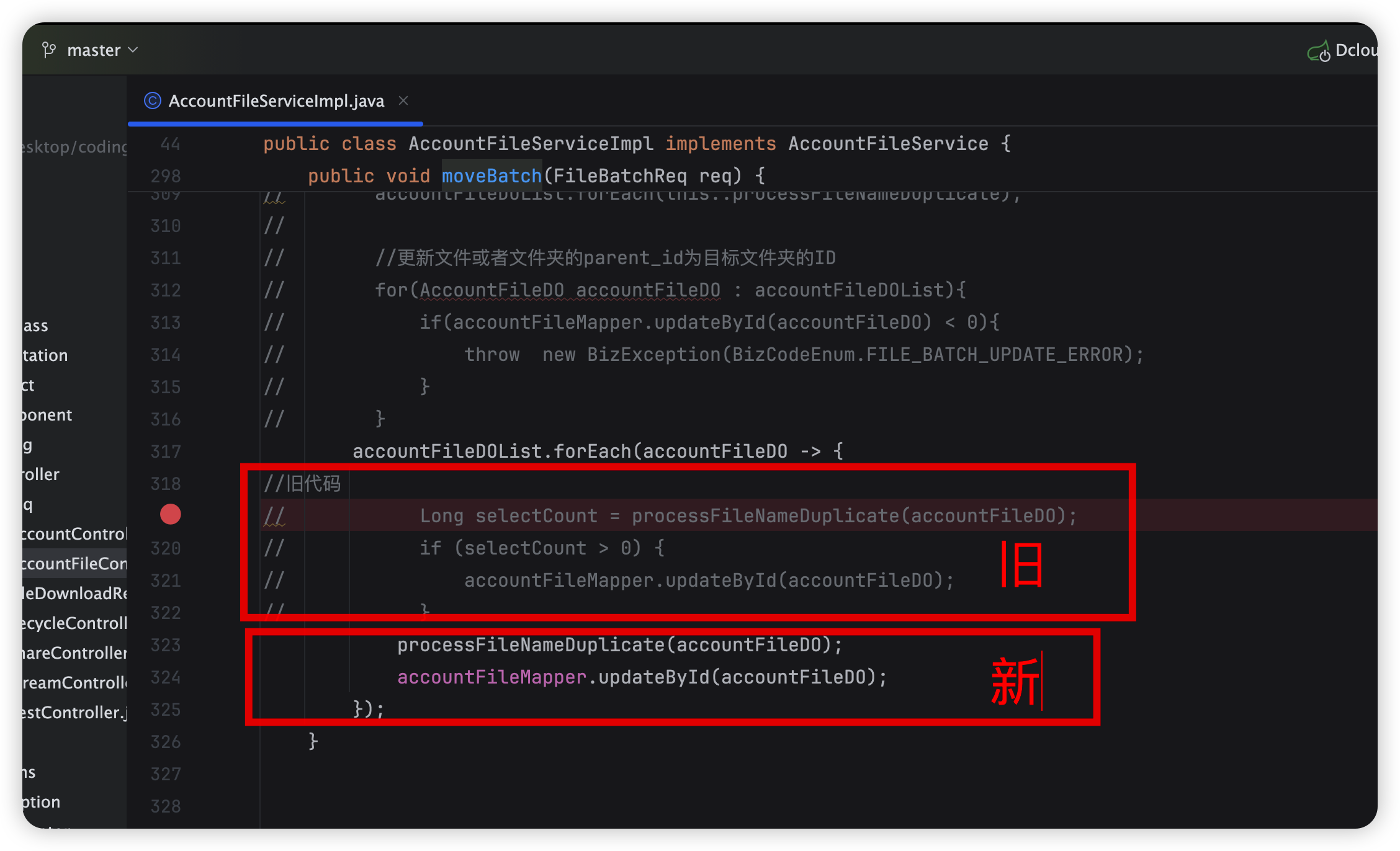

AccountFileDO accountFileDO = accountFileMapper.selectOne(new QueryWrapper * 业务逻辑设计(哪些方法会复用)

* 检查被转移的文件ID是否合法(复用)

* 检查目标文件夹ID是否合法(复用)

* 目标文件夹ID必须是当前用户的文件夹,不能是文件

* 要操作(移动、复制)的文件列表不能包含是目标文件夹的子文件夹,递归处理

* 批量转移文件到目标文件夹

* 处理重复文件名

* 更新文件或文件夹的parentId为目标文件夹ID

* 编码实战

* 业务逻辑设计(哪些方法会复用)

* 检查被转移的文件ID是否合法(复用)

* 检查目标文件夹ID是否合法(复用)

* 目标文件夹ID必须是当前用户的文件夹,不能是文件

* 要操作(移动、复制)的文件列表不能包含是目标文件夹的子文件夹,递归处理

* 批量转移文件到目标文件夹

* 处理重复文件名

* 更新文件或文件夹的parentId为目标文件夹ID

* 编码实战

```java

@Transactional(rollbackFor = Exception.class)

public void moveBatch(FileBatchReq req) {

//检查被转移的文件ID是否合法

List

```java

@Transactional(rollbackFor = Exception.class)

public void moveBatch(FileBatchReq req) {

//检查被转移的文件ID是否合法

List * 编码实现

* 编码实现

* 检查父ID是否合法

```java

private void checkTargetParentIdLegal(FileBatchReq req) {

//1、目标文件夹ID 必须是当前用户的文件夹,不能是文件

AccountFileDO targetParentFolder = accountFileMapper.selectOne(new QueryWrapper

* 检查父ID是否合法

```java

private void checkTargetParentIdLegal(FileBatchReq req) {

//1、目标文件夹ID 必须是当前用户的文件夹,不能是文件

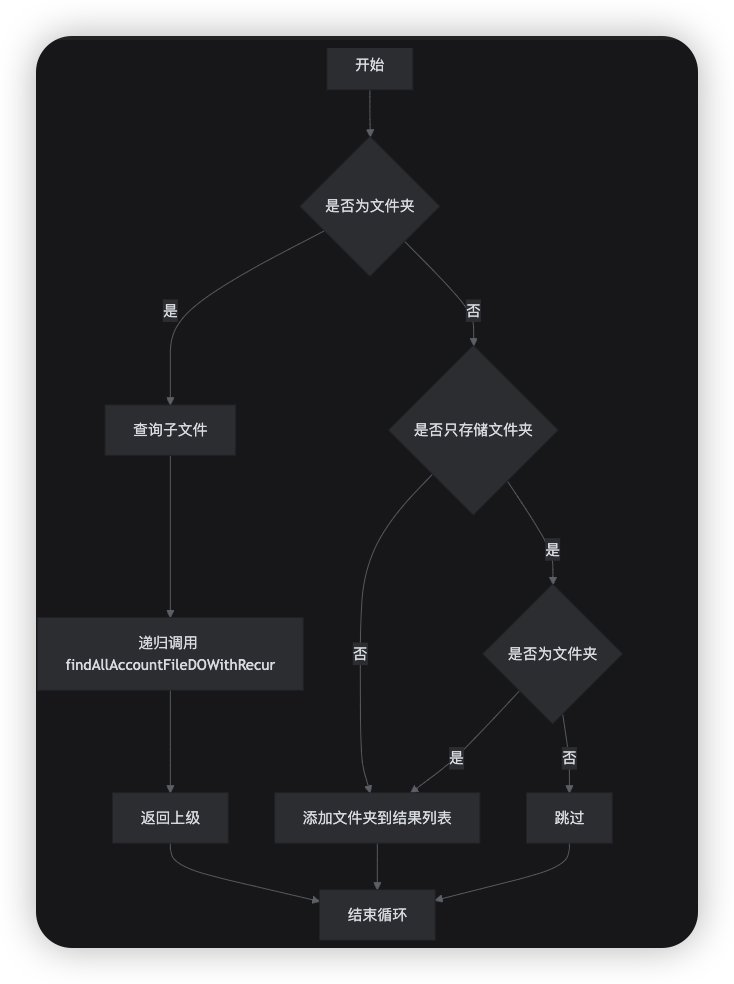

AccountFileDO targetParentFolder = accountFileMapper.selectOne(new QueryWrapper * `findAllAccountFileDOWithRecur` 递归逻辑处理(多个地方会使用,封装方法)

```java

@Override

public void findAllAccountFileDOWithRecur(List

* `findAllAccountFileDOWithRecur` 递归逻辑处理(多个地方会使用,封装方法)

```java

@Override

public void findAllAccountFileDOWithRecur(List * 业务逻辑设计(逐步可以发现,用之前封装好的方法提高效率)

* 步骤一:检查是否满足:1、文件ID数量是否合法,2、文件是否属于当前用户

* 步骤二:判断文件是否是文件夹,文件夹的话需要递归获取里面子文件ID,然后进行批量删除

* 步骤三:需要更新账号存储空间使用情况

* 步骤四:批量删除账号映射文件,考虑回收站如何设计

#### 封装的好处-文件批量删除设计和开发《下》

* 编码实战

```java

public void delBatch(FileDelReq req) {

//步骤一:检查是否满足:1、文件ID数量是否合法 存在和不存在,2、文件是否属于当前用户

List

* 业务逻辑设计(逐步可以发现,用之前封装好的方法提高效率)

* 步骤一:检查是否满足:1、文件ID数量是否合法,2、文件是否属于当前用户

* 步骤二:判断文件是否是文件夹,文件夹的话需要递归获取里面子文件ID,然后进行批量删除

* 步骤三:需要更新账号存储空间使用情况

* 步骤四:批量删除账号映射文件,考虑回收站如何设计

#### 封装的好处-文件批量删除设计和开发《下》

* 编码实战

```java

public void delBatch(FileDelReq req) {

//步骤一:检查是否满足:1、文件ID数量是否合法 存在和不存在,2、文件是否属于当前用户

List * 思考

* 文件复制和文件移动有什么共同逻辑?

* 有什么差异点?

* 业务逻辑设计

* 检查被转移的文件ID是否合法

* 检查目标文件夹ID是否合法

* 执行拷贝,递归查找【差异点,ID是全新的】

* 计算存储空间大小,检查是否足够【差异点,空间需要检查】

* 存储相关记录

* 接口开发

```java

@PostMapping("/copy_batch")

public JsonData copyBatch(@RequestBody FileBatchReq req){

req.setAccountId(LoginInterceptor.threadLocal.get().getId());

fileService.copyBatch(req);

return JsonData.buildSuccess();

}

```

#### 【重点】网盘文件批量复制业务逻辑递归处理实战

* 业务逻辑设计

* 检查被转移的文件ID是否合法

* 检查目标文件夹ID是否合法

* 执行拷贝,递归查找【差异点,ID是全新的】

* 计算存储空间大小,检查是否足够【差异点,空间需要检查】

* 存储相关记录

* 编码实战

* 业务逻辑层

```java

@Override

public void copyBatch(FileBatchReq req) {

//检查被转移的文件ID是否合法

List

* 思考

* 文件复制和文件移动有什么共同逻辑?

* 有什么差异点?

* 业务逻辑设计

* 检查被转移的文件ID是否合法

* 检查目标文件夹ID是否合法

* 执行拷贝,递归查找【差异点,ID是全新的】

* 计算存储空间大小,检查是否足够【差异点,空间需要检查】

* 存储相关记录

* 接口开发

```java

@PostMapping("/copy_batch")

public JsonData copyBatch(@RequestBody FileBatchReq req){

req.setAccountId(LoginInterceptor.threadLocal.get().getId());

fileService.copyBatch(req);

return JsonData.buildSuccess();

}

```

#### 【重点】网盘文件批量复制业务逻辑递归处理实战

* 业务逻辑设计

* 检查被转移的文件ID是否合法

* 检查目标文件夹ID是否合法

* 执行拷贝,递归查找【差异点,ID是全新的】

* 计算存储空间大小,检查是否足够【差异点,空间需要检查】

* 存储相关记录

* 编码实战

* 业务逻辑层

```java

@Override

public void copyBatch(FileBatchReq req) {

//检查被转移的文件ID是否合法

List * 文件秒传功能的需求背景

* 在大文件传输的场景中,尤其是网盘服务,用户经常需要上传相同或相似的文件。

* 传统的上传方式会导致重复数据的多次传输,这不仅浪费了用户的带宽,也增加了服务器的存储压力。

* 为了提高效率和用户体验,文件秒传功能应运而生。

* 文件秒传的核心在于通过快速校验文件的完整性,避免重复上传相同的文件,从而提升传输效率

* 文件秒传设计思路

* **文件哈希值计算**:

* 在文件上传前,客户端计算文件的哈希值(如MD5),一个固定长度的字符串,可以唯一标识文件的内容。

* **哈希值存储与查询**:

* 服务器端维护一个哈希值与文件存储路径的映射关系。

* 新文件上传时,服务器先检查该哈希值是否已存在。

* **秒传逻辑**:

* 如果服务器上已存在相同哈希值的文件,则直接返回文件的存储路径给客户端,客户端无需再次上传,实现秒传。

* **AI智能化网盘逻辑:检查文件是否已经存在,如果存在,直接返回文件ID,建立关联关系,不需要上传,直接秒传成功**

* **冲突处理**:

* 虽然哈希碰撞的概率极低,但仍需考虑不同文件产生相同哈希值的情况。

* 通过增加额外的校验步骤,如文件大小、后缀等元数据信息,来降低误判的风险。

* **安全性考虑**:

* 在实现秒传功能时,需要确保返回给用户的文件路径是安全的,防止路径泄露导致的安全问题

* 比如当前账号下实现文件秒传、当前全部账号下实现文件秒传

#### AI智能化云盘-文件秒传开发实战

* 需求

* 开发文件秒传接口,实现相关功能

* 业务逻辑设计

* 文件秒传 md5检测,是否有这个文件存储

* 检查当前账号的容量是否有

* 如果存在,则直接返回文件ID,建立关联关系,不需要上传,直接秒传成功

* 文件秒传功能的需求背景

* 在大文件传输的场景中,尤其是网盘服务,用户经常需要上传相同或相似的文件。

* 传统的上传方式会导致重复数据的多次传输,这不仅浪费了用户的带宽,也增加了服务器的存储压力。

* 为了提高效率和用户体验,文件秒传功能应运而生。

* 文件秒传的核心在于通过快速校验文件的完整性,避免重复上传相同的文件,从而提升传输效率

* 文件秒传设计思路

* **文件哈希值计算**:

* 在文件上传前,客户端计算文件的哈希值(如MD5),一个固定长度的字符串,可以唯一标识文件的内容。

* **哈希值存储与查询**:

* 服务器端维护一个哈希值与文件存储路径的映射关系。

* 新文件上传时,服务器先检查该哈希值是否已存在。

* **秒传逻辑**:

* 如果服务器上已存在相同哈希值的文件,则直接返回文件的存储路径给客户端,客户端无需再次上传,实现秒传。

* **AI智能化网盘逻辑:检查文件是否已经存在,如果存在,直接返回文件ID,建立关联关系,不需要上传,直接秒传成功**

* **冲突处理**:

* 虽然哈希碰撞的概率极低,但仍需考虑不同文件产生相同哈希值的情况。

* 通过增加额外的校验步骤,如文件大小、后缀等元数据信息,来降低误判的风险。

* **安全性考虑**:

* 在实现秒传功能时,需要确保返回给用户的文件路径是安全的,防止路径泄露导致的安全问题

* 比如当前账号下实现文件秒传、当前全部账号下实现文件秒传

#### AI智能化云盘-文件秒传开发实战

* 需求

* 开发文件秒传接口,实现相关功能

* 业务逻辑设计

* 文件秒传 md5检测,是否有这个文件存储

* 检查当前账号的容量是否有

* 如果存在,则直接返回文件ID,建立关联关系,不需要上传,直接秒传成功

* 编码实战

```java

@Transactional(rollbackFor = Exception.class)

public boolean secondUpload(FileSecondUploadReq req) {

//检查是否有这个文件存储

FileDO fileDO = fileMapper.selectOne(new QueryWrapper

* 编码实战

```java

@Transactional(rollbackFor = Exception.class)

public boolean secondUpload(FileSecondUploadReq req) {

//检查是否有这个文件存储

FileDO fileDO = fileMapper.selectOne(new QueryWrapper * 需求

* 测试文件秒传功能,创建文件夹

* 注册A用户,注册B用户

* A用户上传一个新的文件,B用户也上传同个文件

* 测试结果

* B用户调用文件秒传接口后,自动建立了文件关联关系

* 实现了文件秒传,不用单独上传文件

#### 举一反三能力-文件秒传思想多应用场景

* **举一反三能力:**

* **网盘文件上传中,采用了文件秒传功能,其他类型业务也可以参考类似思想**

* **脱离网盘业务场景,多个不同的互联网行业项目中应用类似解决方案**

* 业务场景说明

* 社交平台 **快速上传文件**:

* 用户可以快速上传相同的文件,实现便捷的操作。

* 通过计算文件的MD5值,如果服务器上已存在相同MD5值的文件

* 则可以直接提供下载链接,无需重新上传,节省了带宽和时间

* 需求

* 测试文件秒传功能,创建文件夹

* 注册A用户,注册B用户

* A用户上传一个新的文件,B用户也上传同个文件

* 测试结果

* B用户调用文件秒传接口后,自动建立了文件关联关系

* 实现了文件秒传,不用单独上传文件

#### 举一反三能力-文件秒传思想多应用场景

* **举一反三能力:**

* **网盘文件上传中,采用了文件秒传功能,其他类型业务也可以参考类似思想**

* **脱离网盘业务场景,多个不同的互联网行业项目中应用类似解决方案**

* 业务场景说明

* 社交平台 **快速上传文件**:

* 用户可以快速上传相同的文件,实现便捷的操作。

* 通过计算文件的MD5值,如果服务器上已存在相同MD5值的文件

* 则可以直接提供下载链接,无需重新上传,节省了带宽和时间

* 企业内部通信 **员工文件共享**:

* 员工可以快速共享相同的文档,节省时间和带宽。

* 企业内部的知识文档管理中,通过文件秒传技术,可以避免重复存储相同的文件,提高存储效率

* 和网盘类似的,也是云存储相关

* 在线教育平台 **在线教学**:

* 在教育行业,教师和学生之间的资料分享是很常见的。

* 借助云盘的秒传功能,教师可以迅速将教学资料分享给学生

* 1个老师发分别送给100个学生,不用上传100次,只需要上传1次即可

* 学生也可以快速提交作业,比如提及给老师和组长,也是实际上传1次,提升了教学效率

* **文件备份**:

* 用户在备份文件时,常常遇到文件过大导致上传时间过长的问题。

* 利用秒传技术,用户可以快速备份已有文件,避免了重复上传的麻烦,节省了大量的时间和带宽。

* 包括数据库、表等定期增量备份的时候也是类似

* **智能缓存**:

* 在用户上传文件的过程中,云盘会对部分常用文件进行智能缓存。

* 当其他用户需要下载同样的文件时,云盘会直接从缓存中提取

* 而不是从原始文件中重新上传,提高文件的下载速度。

* **数据去重**:

* 通过数据去重技术,可以避免重复存储相同文件,从而节省存储空间和提高传输效率

* 比如同样是物理存储的云厂商,只要去重算法足够强大,可以节省很多冗余存储的内容

* 类似网盘,把File表无限放大,做物理存储关系记录

### 大文件上传解决方案和设计开发实战

#### 大文件传输需求背景和常见解决方案《上》

* 企业内部通信 **员工文件共享**:

* 员工可以快速共享相同的文档,节省时间和带宽。

* 企业内部的知识文档管理中,通过文件秒传技术,可以避免重复存储相同的文件,提高存储效率

* 和网盘类似的,也是云存储相关

* 在线教育平台 **在线教学**:

* 在教育行业,教师和学生之间的资料分享是很常见的。

* 借助云盘的秒传功能,教师可以迅速将教学资料分享给学生

* 1个老师发分别送给100个学生,不用上传100次,只需要上传1次即可

* 学生也可以快速提交作业,比如提及给老师和组长,也是实际上传1次,提升了教学效率

* **文件备份**:

* 用户在备份文件时,常常遇到文件过大导致上传时间过长的问题。

* 利用秒传技术,用户可以快速备份已有文件,避免了重复上传的麻烦,节省了大量的时间和带宽。

* 包括数据库、表等定期增量备份的时候也是类似

* **智能缓存**:

* 在用户上传文件的过程中,云盘会对部分常用文件进行智能缓存。

* 当其他用户需要下载同样的文件时,云盘会直接从缓存中提取

* 而不是从原始文件中重新上传,提高文件的下载速度。

* **数据去重**:

* 通过数据去重技术,可以避免重复存储相同文件,从而节省存储空间和提高传输效率

* 比如同样是物理存储的云厂商,只要去重算法足够强大,可以节省很多冗余存储的内容

* 类似网盘,把File表无限放大,做物理存储关系记录

### 大文件上传解决方案和设计开发实战

#### 大文件传输需求背景和常见解决方案《上》

* 需求背景

* 用户上传大文件的需求越来越普遍,尤其是在云存储、视频分享、在线教育等领域

* 大文件上传过程中的网络波动、不稳定性,以及客户端资源的限制,常常给用户带来不佳的体验。

* 传统的整文件上传方式不仅容易因中断而失败,还可能占用大量内存和带宽资源,对用户设备和服务器都造成负担

* 常见问题

* **网络中断风险**

* 上传过程中网络不稳定或意外中断会导致整个上传任务失败,用户需要从头开始重新上传,浪费时间和带宽

* **客户端资源消耗**:

* 大文件上传会占用大量内存和带宽资源,尤其在低配置设备(如移动设备)上,容易导致设备卡顿或资源耗尽

* **服务器负担**:

* 如果没有有效的分片管理和断点续传机制,大文件上传失败后

* 服务器会存储许多不完整或重复的文件,浪费存储资源并增加维护难度

* **用户体验不佳**

* 上传过程中缺乏实时反馈(如进度条),或者因为频繁失败而无法继续上传,会严重影响用户的满意度和使用意愿

* 大文件分片上传常见解决方案之大文件分片上传(Chunked Upload)

* **文件分片**

* 将大文件切成多个小的分片,每个分片单独上传到服务器。

* 这种方式可以提高上传的可靠性和效率,特别是在网络环境不稳定的情况下。

* **分片的标识与管理**:

* 每个分片分配一个唯一标识(如索引或哈希值),以便前后端协作追踪上传状态和重建文件。

* **分片大小的选择策略**

* 分片大小的选择需要综合考虑网络条件、文件大小和服务器性能。

* 通常,分片大小在几MB到几十MB之间较为合适。

* **分片文件合并**

* 文件上传到服务器临时存储空间,等待全部分片都上传完成后,进行合并完成最终的文件

#### 大文件传输需求背景和常见解决方案《下》

* 大文件分片上传后,也存在相关的风险

- **网络中断风险**:上传过程中网络不稳定意外中断会导致整个上传任务失败,用户需要从头开始重新上传,浪费时间和带宽。

- **用户体验不佳**:上传过程中缺乏实时反馈(如进度条),或者频繁失败而无法继续上传,会严重影响用户的满意度。

* 大文件分片上传常见解决方案之断点续传(Resumable Upload)

* 是一种在数据传输过程中,如果发生中断或失败,可以从中断位置继续传输的技术。

* 避免了从头开始重新传输文件,从而节省时间、带宽和资源。

* 这种技术广泛应用于文件传输和下载,以提高数据传输的可靠性和效率

* 工作原理

* **记录传输状态**

* 在数据传输过程中,系统会记录已经成功传输的数据量或位置。

* 系统会在服务器和客户端之间交换一些控制信息,以标记数据传输的进度。

* **中断检测**

* 当数据传输发生中断时,系统会检测到这一情况,并保存当前传输状态。

* 中断可能是由于网络问题、客户端或服务器故障等原因引起的。

* **恢复传输**

* 在传输恢复时,系统会读取之前保存的状态信息,从中断点开始继续传输未完成的数据。

* 这可以减少重复传输的部分,提高传输效率。

* **数据完整性校验**

* 为了确保数据的完整性,客户端在恢复传输时可能会进行数据校验,如MD5校验,确保已传输的数据没有损坏

* 大文件上传中,断点续传的实现步骤

* 文件分片,将大文件分割成多个固定大小的片段(如2MB)

* 上传请求,客户端逐个发送片段上传请求,附带片段序号和文件唯一标识。

* 状态记录,服务器端接收片段,记录上传状态到数据库。

* **断点检测,上传中断后,客户端查询服务器端已上传片段状态(需要查询已经上传的数据)**

* **续传处理,从最后一个成功上传的片段继续上传剩余片段。**

* 文件合并,所有片段上传完成后,服务器端合并片段生成完整文件。

#### 思考能力-大文件传输方案前后端交互逻辑

* **思考:大文件上传交互,前端、后端、文件服务器之前的交互是如何的?**

* **方案一:前端传到服务器,服务器再把文件传输到MinIO**

* 需求背景

* 用户上传大文件的需求越来越普遍,尤其是在云存储、视频分享、在线教育等领域

* 大文件上传过程中的网络波动、不稳定性,以及客户端资源的限制,常常给用户带来不佳的体验。

* 传统的整文件上传方式不仅容易因中断而失败,还可能占用大量内存和带宽资源,对用户设备和服务器都造成负担

* 常见问题

* **网络中断风险**

* 上传过程中网络不稳定或意外中断会导致整个上传任务失败,用户需要从头开始重新上传,浪费时间和带宽

* **客户端资源消耗**:

* 大文件上传会占用大量内存和带宽资源,尤其在低配置设备(如移动设备)上,容易导致设备卡顿或资源耗尽

* **服务器负担**:

* 如果没有有效的分片管理和断点续传机制,大文件上传失败后

* 服务器会存储许多不完整或重复的文件,浪费存储资源并增加维护难度

* **用户体验不佳**

* 上传过程中缺乏实时反馈(如进度条),或者因为频繁失败而无法继续上传,会严重影响用户的满意度和使用意愿

* 大文件分片上传常见解决方案之大文件分片上传(Chunked Upload)

* **文件分片**

* 将大文件切成多个小的分片,每个分片单独上传到服务器。

* 这种方式可以提高上传的可靠性和效率,特别是在网络环境不稳定的情况下。

* **分片的标识与管理**:

* 每个分片分配一个唯一标识(如索引或哈希值),以便前后端协作追踪上传状态和重建文件。

* **分片大小的选择策略**

* 分片大小的选择需要综合考虑网络条件、文件大小和服务器性能。

* 通常,分片大小在几MB到几十MB之间较为合适。

* **分片文件合并**

* 文件上传到服务器临时存储空间,等待全部分片都上传完成后,进行合并完成最终的文件

#### 大文件传输需求背景和常见解决方案《下》

* 大文件分片上传后,也存在相关的风险

- **网络中断风险**:上传过程中网络不稳定意外中断会导致整个上传任务失败,用户需要从头开始重新上传,浪费时间和带宽。

- **用户体验不佳**:上传过程中缺乏实时反馈(如进度条),或者频繁失败而无法继续上传,会严重影响用户的满意度。

* 大文件分片上传常见解决方案之断点续传(Resumable Upload)

* 是一种在数据传输过程中,如果发生中断或失败,可以从中断位置继续传输的技术。

* 避免了从头开始重新传输文件,从而节省时间、带宽和资源。

* 这种技术广泛应用于文件传输和下载,以提高数据传输的可靠性和效率

* 工作原理

* **记录传输状态**

* 在数据传输过程中,系统会记录已经成功传输的数据量或位置。

* 系统会在服务器和客户端之间交换一些控制信息,以标记数据传输的进度。

* **中断检测**

* 当数据传输发生中断时,系统会检测到这一情况,并保存当前传输状态。

* 中断可能是由于网络问题、客户端或服务器故障等原因引起的。

* **恢复传输**

* 在传输恢复时,系统会读取之前保存的状态信息,从中断点开始继续传输未完成的数据。

* 这可以减少重复传输的部分,提高传输效率。

* **数据完整性校验**

* 为了确保数据的完整性,客户端在恢复传输时可能会进行数据校验,如MD5校验,确保已传输的数据没有损坏

* 大文件上传中,断点续传的实现步骤

* 文件分片,将大文件分割成多个固定大小的片段(如2MB)

* 上传请求,客户端逐个发送片段上传请求,附带片段序号和文件唯一标识。

* 状态记录,服务器端接收片段,记录上传状态到数据库。

* **断点检测,上传中断后,客户端查询服务器端已上传片段状态(需要查询已经上传的数据)**

* **续传处理,从最后一个成功上传的片段继续上传剩余片段。**

* 文件合并,所有片段上传完成后,服务器端合并片段生成完整文件。

#### 思考能力-大文件传输方案前后端交互逻辑

* **思考:大文件上传交互,前端、后端、文件服务器之前的交互是如何的?**

* **方案一:前端传到服务器,服务器再把文件传输到MinIO**

* 优点

* **集中管理**:

* 所有文件上传操作都通过后端进行集中管理,可以方便地实现身份验证、权限控制、文件处理等业务逻辑。

* 例如,可以在文件上传到MinIO之前生成缩略图或提取元数据。

* **安全性**

* 后端可以作为中间层,对上传的文件进行安全检查和过滤,防止恶意文件上传到MinIO。

* **业务逻辑扩展**

* 可以在文件上传过程中加入更多的业务逻辑,如文件内容的预处理、格式转换等

* 缺点

* **性能压力**:

* 后端服务器需要处理文件的中转,增加了服务器的负载和响应时间。

* 特别是对于大文件,后端需要先接收文件,再将其传输到MinIO,这会显著增加延迟。

* **单点故障**:

* 如果后端服务器出现故障,整个文件上传流程将受到影响,即使MinIO服务正常运行,也无法完成文件上传。

* **资源占用**

* 后端服务器需要额外的资源来处理文件流,会导致服务器资源紧张,尤其是在高并发场景下。

* **方案二:前端直接传输到MinIO(课程采取的方案)**

* 优点

* **集中管理**:

* 所有文件上传操作都通过后端进行集中管理,可以方便地实现身份验证、权限控制、文件处理等业务逻辑。

* 例如,可以在文件上传到MinIO之前生成缩略图或提取元数据。

* **安全性**

* 后端可以作为中间层,对上传的文件进行安全检查和过滤,防止恶意文件上传到MinIO。

* **业务逻辑扩展**

* 可以在文件上传过程中加入更多的业务逻辑,如文件内容的预处理、格式转换等

* 缺点

* **性能压力**:

* 后端服务器需要处理文件的中转,增加了服务器的负载和响应时间。

* 特别是对于大文件,后端需要先接收文件,再将其传输到MinIO,这会显著增加延迟。

* **单点故障**:

* 如果后端服务器出现故障,整个文件上传流程将受到影响,即使MinIO服务正常运行,也无法完成文件上传。

* **资源占用**

* 后端服务器需要额外的资源来处理文件流,会导致服务器资源紧张,尤其是在高并发场景下。

* **方案二:前端直接传输到MinIO(课程采取的方案)**

* **优点**:

* **减少延迟**:前端直接将文件上传到MinIO,减少了文件在后端的中转时间,显著提高了上传效率。

* **减轻后端压力**:后端服务器不需要处理文件的中转,可以专注于业务逻辑处理,减少了服务器的负载。

* **高可用性**:即使后端服务器出现故障,只要MinIO服务正常运行,文件上传仍然可以继续进行,提高了系统的高可用性。

* **缺点**:

* **安全性**:

* 前端直接上传文件到MinIO,需要生成并返回一个有时效的上传凭证,

* 增加了安全风险。需要确保上传凭证的安全性,防止被恶意利用。

* **权限控制**:

* 虽然可以通过上传凭证实现一定程度的权限控制,但相比后端集中管理,权限控制的灵活性和安全性可能会稍弱。

* **业务逻辑限制**:

* 前端直接上传文件到MinIO,后端无法在文件上传过程中加入复杂的业务逻辑,如文件内容的预处理、格式转换等。

* **前端直接传输到MinIO 交互时序图讲解**

* **优点**:

* **减少延迟**:前端直接将文件上传到MinIO,减少了文件在后端的中转时间,显著提高了上传效率。

* **减轻后端压力**:后端服务器不需要处理文件的中转,可以专注于业务逻辑处理,减少了服务器的负载。

* **高可用性**:即使后端服务器出现故障,只要MinIO服务正常运行,文件上传仍然可以继续进行,提高了系统的高可用性。

* **缺点**:

* **安全性**:

* 前端直接上传文件到MinIO,需要生成并返回一个有时效的上传凭证,

* 增加了安全风险。需要确保上传凭证的安全性,防止被恶意利用。

* **权限控制**:

* 虽然可以通过上传凭证实现一定程度的权限控制,但相比后端集中管理,权限控制的灵活性和安全性可能会稍弱。

* **业务逻辑限制**:

* 前端直接上传文件到MinIO,后端无法在文件上传过程中加入复杂的业务逻辑,如文件内容的预处理、格式转换等。

* **前端直接传输到MinIO 交互时序图讲解**

#### AWS-S3大文件和原生API方案优缺点对比

* ##### 大文件分片上传基本原理

- **文件上传**:将客户端的文件通过HTTP协议传输到服务器端,并在服务器端进行存储。

- **分片上传**:将大文件拆分成多个小块,逐一上传,最后在服务器端进行合并。

* **前端实现**:

- 使用HTML5的`File` API和`Blob`对象来读取文件并分割成小块。

- 使用AJAX技术将文件分块发送到后端,也可以采用其他方式

* 原生编写Java实现大文件上传和使用AWS-S3的API优缺点对比

* 原生方式

* **后端实现**:

- 使用`javax.servlet`和`javax.servlet.http`包中的类来处理文件上传。

- 获取`request`对象中的文件项,通过`getInputStream()`方法获取输入流,将文件内容写入服务器上的指定位置

* **优点**:

- **灵活性高**:可以根据具体需求进行定制,例如实现断点续传、文件的读取、分块、传输和合并。

* **缺点**:

- **复杂度高**:需要手动处理文件的分块、传输和合并,代码复杂度较高。

* 使用AWS-S3的API

* **后端实现**

* `aws-java-sdk-s3` 已经封装了相关API,直接调用即可

* 包括初始化分片上传任务、查询已经传输的分片、获取临时上传的预签名地址、合并分片文件等相关API

* **优点**

* 开发效率高:SDK提供了丰富的API,简化大文件上传的开发过程,利用现成的解决方案,具有良好的兼容性和稳定性

* **缺点**

* **学习曲线**: 需要学习AWS S3的API和相关概念,有一定的学习成本

* 接口测试说明

* 第一步:测试初始化分片任务, 获取uploadId

* 如果初始化时有 uploadId,说明是断点续传,不能重新生成 uploadId

* 第二步:测试初始化并生成多个预签名URL,返回给前端

* 获取多个分片上传地址,返回临时MinIO地址,前端直接上传到Minio里面

* 第三步:合并分片

* 用uploadId标识特定的分片上传事件,检查分片数量是否与预期一致,然后合并

* 其他步骤:获取已经上传的分片文件, 未上传完成,调用接口获取上传进度

* 接口测试实战

```java

@Test

public void testInitMultipartUploadTask() {

// 定义对象键名

String objectKey = "/meta/test5.txt";

// 定义存储桶名称

String bucket = "ai-pan";

// 创建对象元数据,并设置内容类型

ObjectMetadata metadata = new ObjectMetadata();

metadata.setContentType("text/plain");

// 创建初始化分部分上传请求

InitiateMultipartUploadRequest initRequest = new InitiateMultipartUploadRequest(bucket, objectKey, metadata);

// 初始化分部分上传,并获取上传ID

String uploadId = amazonS3Client.initiateMultipartUpload(initRequest).getUploadId();

log.info("uploadId:{}", uploadId);

}

```

#### AWS-S3大文件上传API测试预签名URL实战

* 需求:测试下面相关API

* 第一步:测试初始化分片任务上传, 获取uploadId

* 如果初始化时有 uploadId,说明是断点续传,不能重新生成 uploadId

* 第二步:测试初始化并生成多个预签名URL,返回给前端

* 获取多个分片上传地址,返回临时MinIO地址,前端直接上传到Minio里面

* 第三步:合并分片

* 用uploadId标识特定的分片上传事件,检查分片数量是否与预期一致,然后合并

* 其他步骤:获取已经上传的分片文件, 未上传完成,调用接口获取上传进度

* 测试实战

* 第二步:测试初始化并生成多个预签名URL,返回给前端

```java

@Test

public void testGenePreSignedUrls() {

// 定义对象键名

String objectKey = "/meta/test5.txt";

// 定义存储桶名称

String bucket = "ai-pan";

// 定义分片数量,这里设置为4个分片

int chunkCount = 4;

String uploadId = "ZjFkZjRhN2UtNzMzOS00NTUxLTgwOTEtNWViNzUwNmRmYTEzLmE4NTUyMmQyLTM1NjgtNGMwMS05ZTY2LWQ1MWQ3NGVkNmY2YQ";

// 创建用于存储分片URL的列表

List

#### AWS-S3大文件和原生API方案优缺点对比

* ##### 大文件分片上传基本原理

- **文件上传**:将客户端的文件通过HTTP协议传输到服务器端,并在服务器端进行存储。

- **分片上传**:将大文件拆分成多个小块,逐一上传,最后在服务器端进行合并。

* **前端实现**:

- 使用HTML5的`File` API和`Blob`对象来读取文件并分割成小块。

- 使用AJAX技术将文件分块发送到后端,也可以采用其他方式

* 原生编写Java实现大文件上传和使用AWS-S3的API优缺点对比

* 原生方式

* **后端实现**:

- 使用`javax.servlet`和`javax.servlet.http`包中的类来处理文件上传。

- 获取`request`对象中的文件项,通过`getInputStream()`方法获取输入流,将文件内容写入服务器上的指定位置

* **优点**:

- **灵活性高**:可以根据具体需求进行定制,例如实现断点续传、文件的读取、分块、传输和合并。

* **缺点**:

- **复杂度高**:需要手动处理文件的分块、传输和合并,代码复杂度较高。

* 使用AWS-S3的API

* **后端实现**

* `aws-java-sdk-s3` 已经封装了相关API,直接调用即可

* 包括初始化分片上传任务、查询已经传输的分片、获取临时上传的预签名地址、合并分片文件等相关API

* **优点**

* 开发效率高:SDK提供了丰富的API,简化大文件上传的开发过程,利用现成的解决方案,具有良好的兼容性和稳定性

* **缺点**

* **学习曲线**: 需要学习AWS S3的API和相关概念,有一定的学习成本

* 接口测试说明

* 第一步:测试初始化分片任务, 获取uploadId

* 如果初始化时有 uploadId,说明是断点续传,不能重新生成 uploadId

* 第二步:测试初始化并生成多个预签名URL,返回给前端

* 获取多个分片上传地址,返回临时MinIO地址,前端直接上传到Minio里面

* 第三步:合并分片

* 用uploadId标识特定的分片上传事件,检查分片数量是否与预期一致,然后合并

* 其他步骤:获取已经上传的分片文件, 未上传完成,调用接口获取上传进度

* 接口测试实战

```java

@Test

public void testInitMultipartUploadTask() {

// 定义对象键名

String objectKey = "/meta/test5.txt";

// 定义存储桶名称

String bucket = "ai-pan";

// 创建对象元数据,并设置内容类型

ObjectMetadata metadata = new ObjectMetadata();

metadata.setContentType("text/plain");

// 创建初始化分部分上传请求

InitiateMultipartUploadRequest initRequest = new InitiateMultipartUploadRequest(bucket, objectKey, metadata);

// 初始化分部分上传,并获取上传ID

String uploadId = amazonS3Client.initiateMultipartUpload(initRequest).getUploadId();

log.info("uploadId:{}", uploadId);

}

```

#### AWS-S3大文件上传API测试预签名URL实战

* 需求:测试下面相关API

* 第一步:测试初始化分片任务上传, 获取uploadId

* 如果初始化时有 uploadId,说明是断点续传,不能重新生成 uploadId

* 第二步:测试初始化并生成多个预签名URL,返回给前端

* 获取多个分片上传地址,返回临时MinIO地址,前端直接上传到Minio里面

* 第三步:合并分片

* 用uploadId标识特定的分片上传事件,检查分片数量是否与预期一致,然后合并

* 其他步骤:获取已经上传的分片文件, 未上传完成,调用接口获取上传进度

* 测试实战

* 第二步:测试初始化并生成多个预签名URL,返回给前端

```java

@Test

public void testGenePreSignedUrls() {

// 定义对象键名

String objectKey = "/meta/test5.txt";

// 定义存储桶名称

String bucket = "ai-pan";

// 定义分片数量,这里设置为4个分片

int chunkCount = 4;

String uploadId = "ZjFkZjRhN2UtNzMzOS00NTUxLTgwOTEtNWViNzUwNmRmYTEzLmE4NTUyMmQyLTM1NjgtNGMwMS05ZTY2LWQ1MWQ3NGVkNmY2YQ";

// 创建用于存储分片URL的列表

List * 测试思路

* 使用后端Java代码进行文件读取

* 根据进行切割成不同的小文件

* 再调用对应的大文件分片上传任务初始化接口

* 获取分片上传地址,返回临时MinIO地址

* 使用HttpClient模拟前端直接上传分片到minio

* 调用分片文件合并接口

* 查询分片上传进度接口

* 编码实战

* 使用后端Java代码进行文件读取

* 根据进行切割成不同的小文件

```

SpringBootTest

@Slf4j

class FileChunkUploadTests {

@Autowired

private FileChunkService fileChunkService;

private Long accountId = 3L;

private String identifier = "abcsdfsd";

/**

* 存储分片后端的文件路径和名称

*/

private final List

* 测试思路

* 使用后端Java代码进行文件读取

* 根据进行切割成不同的小文件

* 再调用对应的大文件分片上传任务初始化接口

* 获取分片上传地址,返回临时MinIO地址

* 使用HttpClient模拟前端直接上传分片到minio

* 调用分片文件合并接口

* 查询分片上传进度接口

* 编码实战

* 使用后端Java代码进行文件读取

* 根据进行切割成不同的小文件

```

SpringBootTest

@Slf4j

class FileChunkUploadTests {

@Autowired

private FileChunkService fileChunkService;

private Long accountId = 3L;

private String identifier = "abcsdfsd";

/**

* 存储分片后端的文件路径和名称

*/

private final List * 测试实战

* 检查分片文件是否生成

* 检查MinIO是否有对应的文件

* 检查数据库是否有对应的文件

* 注意

* MinIO显示的文件大小和实际的有出入,是界面显示问题,实际的为准

* 可以合并文件后下载下来打开对比

**愿景:"IT路上的持续充电平台,让技术不再难学"**

**更多高级课程请访问 xdclass.net**

### 第十五章 网盘文件分享模块设计和开发实战

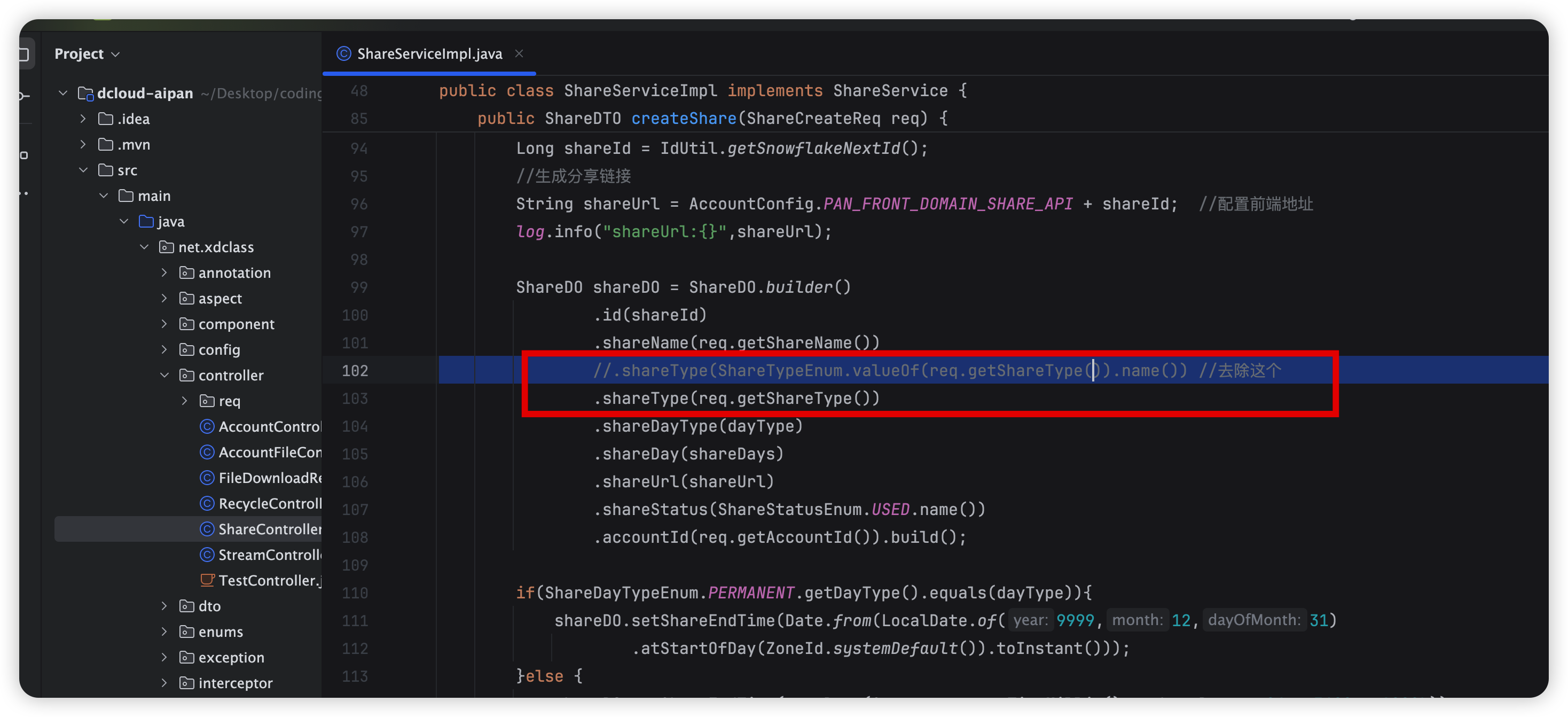

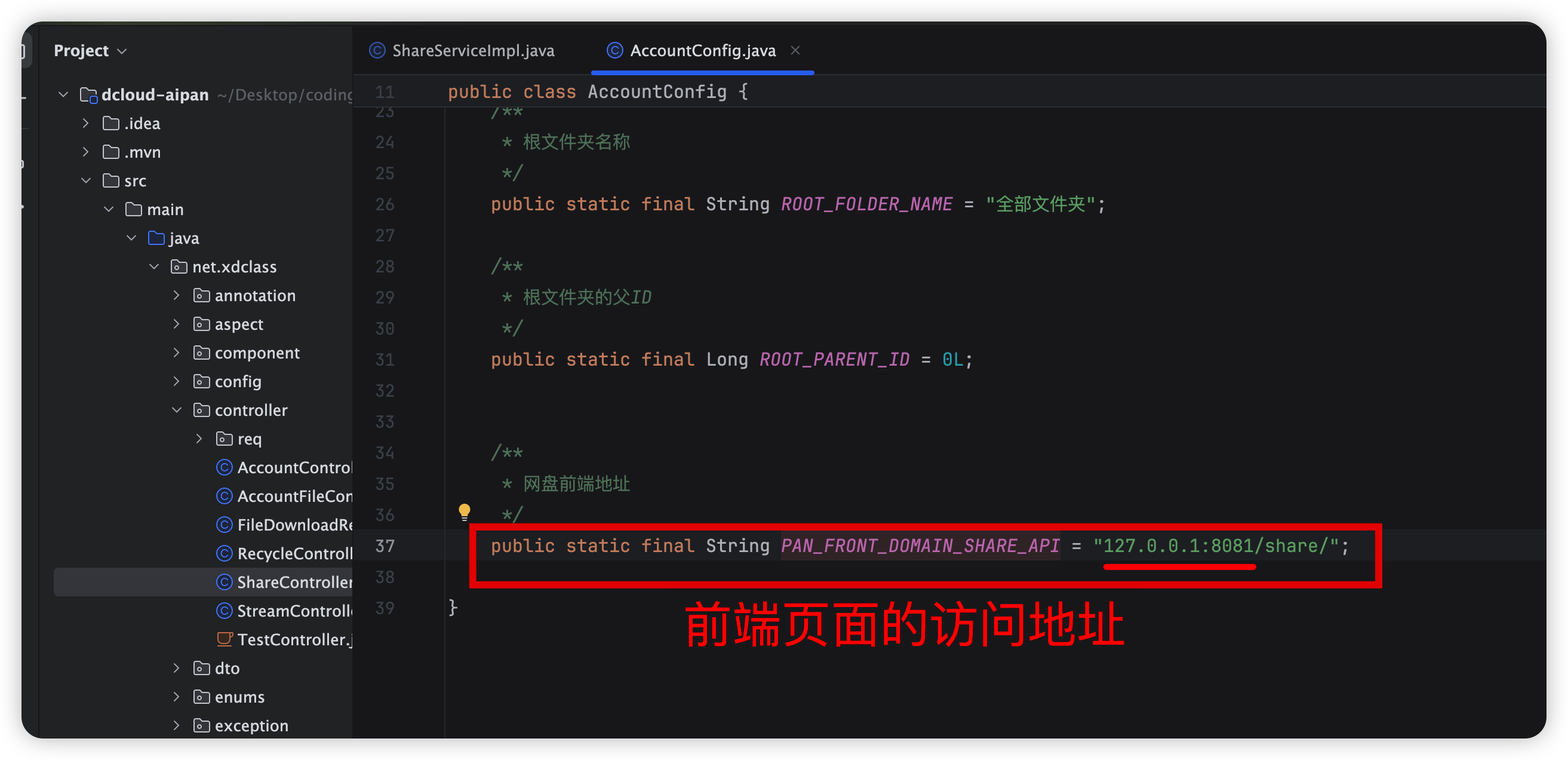

#### 第1集 文件分享转存需求背景和数据库表说明

**简介: 文件分享转存需求背景和数据库表说明**

* 需求

* 老王有几十G《冰冰的游泳视频》存储在小滴网盘上面

* 需要分享给老帆,但是又不能公开分享下载,所以需要开发分享转存功能

* AI智能云盘分享文件

* 支持多个文件批量公开分享和加密分享

* 支持查看我的分享链接和取消分享

* 支持配置分享链接的有效期,包括 永久有效、7天有效、30天有效

* 数据库表说明

* share主表

* share_file子表

#### 第2集 文件分享枚举定义和分享列表接口开发

**简介: 文件分享枚举定义和分享列表接口开发**

* 需求

* 定位文件分享模块相关枚举类

* 查询我的文件分享列表

* 编码实战

* 提取码枚举

```

@Getter

public enum ShareTypeEnum {

/**

* 没有提取码

*/

NO_CODE,

/**

* 有提取码

*/

NEED_CODE;

}

```

* 分享状态

```

/**

* 分享状态 used正常, expired已失效, cancled取消

*/

public enum ShareStatusEnum {

USED,

EXPIRED,

CANCELED;

}

```

* 分享链接时效性枚举

```

//分享类型(0 永久有效;1: 7天有效;2: 30天有效)

@AllArgsConstructor

@Getter

public enum ShareDayTypeEnum {

PERMANENT(0,0),

SEVEN_DAYS(1,7),

THIRTY_DAYS(2,30);

private Integer dayType;

private Integer days;

/**

* 根据类型获取对应的天数

*/

public static Integer getDaysByType(Integer dayType) {

for (ShareDayTypeEnum value : ShareDayTypeEnum.values()) {

if(value.getDayType().equals(dayType)){

return value.getDays();

}

}

//默认7天

return SEVEN_DAYS.days;

}

}

```

* 我的分享列表接口

```

@Override

public List

* 测试实战

* 检查分片文件是否生成

* 检查MinIO是否有对应的文件

* 检查数据库是否有对应的文件

* 注意

* MinIO显示的文件大小和实际的有出入,是界面显示问题,实际的为准

* 可以合并文件后下载下来打开对比

**愿景:"IT路上的持续充电平台,让技术不再难学"**

**更多高级课程请访问 xdclass.net**

### 第十五章 网盘文件分享模块设计和开发实战

#### 第1集 文件分享转存需求背景和数据库表说明

**简介: 文件分享转存需求背景和数据库表说明**

* 需求

* 老王有几十G《冰冰的游泳视频》存储在小滴网盘上面

* 需要分享给老帆,但是又不能公开分享下载,所以需要开发分享转存功能

* AI智能云盘分享文件

* 支持多个文件批量公开分享和加密分享

* 支持查看我的分享链接和取消分享

* 支持配置分享链接的有效期,包括 永久有效、7天有效、30天有效

* 数据库表说明

* share主表

* share_file子表

#### 第2集 文件分享枚举定义和分享列表接口开发

**简介: 文件分享枚举定义和分享列表接口开发**

* 需求

* 定位文件分享模块相关枚举类

* 查询我的文件分享列表

* 编码实战

* 提取码枚举

```

@Getter

public enum ShareTypeEnum {

/**

* 没有提取码

*/

NO_CODE,

/**

* 有提取码

*/

NEED_CODE;

}

```

* 分享状态

```

/**

* 分享状态 used正常, expired已失效, cancled取消

*/

public enum ShareStatusEnum {

USED,

EXPIRED,

CANCELED;

}

```

* 分享链接时效性枚举

```

//分享类型(0 永久有效;1: 7天有效;2: 30天有效)

@AllArgsConstructor

@Getter

public enum ShareDayTypeEnum {

PERMANENT(0,0),

SEVEN_DAYS(1,7),

THIRTY_DAYS(2,30);

private Integer dayType;

private Integer days;

/**

* 根据类型获取对应的天数

*/

public static Integer getDaysByType(Integer dayType) {

for (ShareDayTypeEnum value : ShareDayTypeEnum.values()) {

if(value.getDayType().equals(dayType)){

return value.getDays();

}

}

//默认7天

return SEVEN_DAYS.days;

}

}

```

* 我的分享列表接口

```

@Override

public List  **愿景:"IT路上的持续充电平台,让技术不再难学"**

**更多高级课程请访问 xdclass.net**

### 第十六章 自定义注解+AOP实战文件分享设计实战

#### 第1集 【业务难点】查看他人分享文件列表业务设计

**简介: 【业务难点】查看他人分享文件列表业务设计**

* 需求

* 通过别人分享的文件链接,查看对应分享的文件(注意:需要先登录自己网盘才可以查看分享信息)

* 选择部分或者全部分享的文件,或者进入对应的文件夹,转存到自己网盘

**愿景:"IT路上的持续充电平台,让技术不再难学"**

**更多高级课程请访问 xdclass.net**

### 第十六章 自定义注解+AOP实战文件分享设计实战

#### 第1集 【业务难点】查看他人分享文件列表业务设计

**简介: 【业务难点】查看他人分享文件列表业务设计**

* 需求

* 通过别人分享的文件链接,查看对应分享的文件(注意:需要先登录自己网盘才可以查看分享信息)

* 选择部分或者全部分享的文件,或者进入对应的文件夹,转存到自己网盘

* 思考难点

* 上述业务逻辑如何实现?

* 如果是需要提求取码的链接,如何第一次校验,后续可以不校验,实现安全访问?

* 如何确保不被越权访问?

* 前后端交互逻辑和解决方案

* 用户访问分享链接,统一调用后端【基本分享信息】接口 `/api/share/v1/visit?shareId=XXXX`

* 上述接口会返回基本分享信息,**包括:是否需要提取码、分享人信息 等**

* 前端根据访问的基本分享信息,是否需要提取码,分两个情况

* 情况一

* 免提取码,基本分享信息返回里面有token,请求头携带过去 即可直接使用访问对应的分享文件

* 调用 `/api/share/v1/detail` 接口,访问链接之间进入文件列表

* 情况二

* 需要提取码,基本分享信息里面无token,先进入提取码界面,可以看到分享人信息

* 输入提取码后校验,成功则后端会返回token,请求头携带过去 即可直接使用访问对应的分享文件

* 调用 `/api/share/v1/detail` 接口,访问链接之间进入文件列表

* 进入分享文件的子文件,则统一调用接口 `/api/share/v1/list_share_file` (需要携带token)

* **思考下:如果是你设计,是否还有其他的设计方案,群里讨论**

#### 第2集 AI智能化云盘-基本分享信息接口开发实战

**简介: AI智能化云盘-基本分享信息接口开发实战**

* 需求

* 用户访问分享链接,进入对应的分享文件页面

* 业务逻辑

* 检查分享状态

* 查询分享记录实体

* 查询分享者信息

* 判断是否需要生成校验码,不需要的话可以直接生成分享token

* 编码实战

* 业务逻辑开发

```

@Override

public ShareSimpleDTO simpleDetail(Long shareId) {

//1、检查分享状态

ShareDO shareDO = checkShareStatus(shareId);

//2、查询分享记录实体

ShareSimpleDTO shareSimpleDTO = SpringBeanUtil.copyProperties(shareDO, ShareSimpleDTO.class);

//3、查询分享者信息

ShareAccountDTO shareAccountDTO = getShareAccount(shareDO.getAccountId());

shareSimpleDTO.setShareAccountDTO(shareAccountDTO);

//判断是否需要生成校验码,不需要的话可以直接生成分享token

if (ShareTypeEnum.NO_CODE.name().equalsIgnoreCase(shareDO.getShareType())) {

shareSimpleDTO.setShareToken(JwtUtil.geneShareJWT(shareDO.getId()));

}

return shareSimpleDTO;

}

```

* 令牌生成

```

/**

* 创建分享的令牌

*/

public static String geneShareJWT( Object claimValue) {

// 创建 JWT token

String compact = Jwts.builder()

.subject(SHARE_SUBJECT)

.claim(CLAIM_SHARE_KEY, claimValue)

.issuedAt(new Date())

.expiration(new Date(System.currentTimeMillis() + SHARE_TOKEN_EXPIRE))

.signWith(KEY, ALGORITHM) // 直接使用KEY即可

.compact();

return compact;

}

/**

* 创建分享的令牌

*/

public static Claims checkShareJWT(String token) {

try {

log.debug("开始校验 Share JWT: {}", token);

// 校验 Token 是否为空

if (token == null || token.trim().isEmpty()) {

log.error("Share Token 不能为空");

return null;

}

token = token.trim();

// 解析 JWT

Claims payload = Jwts.parser()

.verifyWith(KEY) //设置签名的密钥, 使用相同的 KEY

.build()

.parseSignedClaims(token).getPayload();

log.info("Share JWT 解密成功,Claims: {}", payload);

return payload;

} catch (IllegalArgumentException e) {

log.error("JWT 校验失败: {}", e.getMessage(), e);

} catch (io.jsonwebtoken.security.SignatureException e) {

log.error("JWT 签名验证失败: {}", e.getMessage(), e);

} catch (io.jsonwebtoken.ExpiredJwtException e) {

log.error("JWT 已过期: {}", e.getMessage(), e);

} catch (Exception e) {

log.error("JWT 解密失败: {}", e.getMessage(), e);

}

return null;

}

```

#### 第3集 AI智能化云盘-分享链接校验码接口开发

**简介: AI智能化云盘-分享链接校验码提口开发**

* 需求

* 开发校验分享码,方便后续访问,返回临时的token

* 业务逻辑

* 检查分享链接是否存在和过期

* 校验提取码是否正确

* 编码实战

```

public String checkShareCode(ShareCheckReq req) {

ShareDO shareDO = shareMapper.selectOne(new QueryWrapper

* 思考难点

* 上述业务逻辑如何实现?

* 如果是需要提求取码的链接,如何第一次校验,后续可以不校验,实现安全访问?

* 如何确保不被越权访问?

* 前后端交互逻辑和解决方案

* 用户访问分享链接,统一调用后端【基本分享信息】接口 `/api/share/v1/visit?shareId=XXXX`

* 上述接口会返回基本分享信息,**包括:是否需要提取码、分享人信息 等**

* 前端根据访问的基本分享信息,是否需要提取码,分两个情况

* 情况一

* 免提取码,基本分享信息返回里面有token,请求头携带过去 即可直接使用访问对应的分享文件

* 调用 `/api/share/v1/detail` 接口,访问链接之间进入文件列表

* 情况二

* 需要提取码,基本分享信息里面无token,先进入提取码界面,可以看到分享人信息

* 输入提取码后校验,成功则后端会返回token,请求头携带过去 即可直接使用访问对应的分享文件

* 调用 `/api/share/v1/detail` 接口,访问链接之间进入文件列表

* 进入分享文件的子文件,则统一调用接口 `/api/share/v1/list_share_file` (需要携带token)

* **思考下:如果是你设计,是否还有其他的设计方案,群里讨论**

#### 第2集 AI智能化云盘-基本分享信息接口开发实战

**简介: AI智能化云盘-基本分享信息接口开发实战**

* 需求

* 用户访问分享链接,进入对应的分享文件页面

* 业务逻辑

* 检查分享状态

* 查询分享记录实体

* 查询分享者信息

* 判断是否需要生成校验码,不需要的话可以直接生成分享token

* 编码实战

* 业务逻辑开发

```

@Override

public ShareSimpleDTO simpleDetail(Long shareId) {

//1、检查分享状态

ShareDO shareDO = checkShareStatus(shareId);

//2、查询分享记录实体

ShareSimpleDTO shareSimpleDTO = SpringBeanUtil.copyProperties(shareDO, ShareSimpleDTO.class);

//3、查询分享者信息

ShareAccountDTO shareAccountDTO = getShareAccount(shareDO.getAccountId());

shareSimpleDTO.setShareAccountDTO(shareAccountDTO);

//判断是否需要生成校验码,不需要的话可以直接生成分享token

if (ShareTypeEnum.NO_CODE.name().equalsIgnoreCase(shareDO.getShareType())) {

shareSimpleDTO.setShareToken(JwtUtil.geneShareJWT(shareDO.getId()));

}

return shareSimpleDTO;

}

```

* 令牌生成

```

/**

* 创建分享的令牌

*/

public static String geneShareJWT( Object claimValue) {

// 创建 JWT token

String compact = Jwts.builder()

.subject(SHARE_SUBJECT)

.claim(CLAIM_SHARE_KEY, claimValue)

.issuedAt(new Date())

.expiration(new Date(System.currentTimeMillis() + SHARE_TOKEN_EXPIRE))

.signWith(KEY, ALGORITHM) // 直接使用KEY即可

.compact();

return compact;

}

/**

* 创建分享的令牌

*/

public static Claims checkShareJWT(String token) {

try {

log.debug("开始校验 Share JWT: {}", token);

// 校验 Token 是否为空

if (token == null || token.trim().isEmpty()) {

log.error("Share Token 不能为空");

return null;

}

token = token.trim();

// 解析 JWT

Claims payload = Jwts.parser()

.verifyWith(KEY) //设置签名的密钥, 使用相同的 KEY

.build()

.parseSignedClaims(token).getPayload();

log.info("Share JWT 解密成功,Claims: {}", payload);

return payload;

} catch (IllegalArgumentException e) {

log.error("JWT 校验失败: {}", e.getMessage(), e);

} catch (io.jsonwebtoken.security.SignatureException e) {

log.error("JWT 签名验证失败: {}", e.getMessage(), e);

} catch (io.jsonwebtoken.ExpiredJwtException e) {

log.error("JWT 已过期: {}", e.getMessage(), e);

} catch (Exception e) {

log.error("JWT 解密失败: {}", e.getMessage(), e);

}

return null;

}

```

#### 第3集 AI智能化云盘-分享链接校验码接口开发

**简介: AI智能化云盘-分享链接校验码提口开发**

* 需求

* 开发校验分享码,方便后续访问,返回临时的token

* 业务逻辑

* 检查分享链接是否存在和过期

* 校验提取码是否正确

* 编码实战

```

public String checkShareCode(ShareCheckReq req) {

ShareDO shareDO = shareMapper.selectOne(new QueryWrapper * 业务逻辑

* 查询分享记录实体

* 检查分享状态

* 查询分享文件信息

* 查询分享者信息

* 构造分析详情对象返回

* 编码实战

```

public ShareDetailDTO detail(Long shareId) {

//1、查询分享记录实体,检查分享状态

ShareDO shareDO = checkShareStatus(shareId);

ShareDetailDTO shareDetailDTO = SpringBeanUtil.copyProperties(shareDO, ShareDetailDTO.class);

//3、查询分享文件信息

List

* 业务逻辑

* 查询分享记录实体

* 检查分享状态

* 查询分享文件信息

* 查询分享者信息

* 构造分析详情对象返回

* 编码实战

```

public ShareDetailDTO detail(Long shareId) {

//1、查询分享记录实体,检查分享状态

ShareDO shareDO = checkShareStatus(shareId);

ShareDetailDTO shareDetailDTO = SpringBeanUtil.copyProperties(shareDO, ShareDetailDTO.class);

//3、查询分享文件信息

List  **愿景:"IT路上的持续充电平台,让技术不再难学"**

**更多高级课程请访问 xdclass.net**

### 第十八章 AI网盘回收站设计和编码开发实战

#### 第1集 网盘回收站需求背景和业务逻辑讲解

**简介: 网盘回收站需求背景和业务逻辑讲解**

* 业务需求

* **文件删除:**

- 用户删除文件或文件夹时,系统并非真正删除数据,而是将其移动到回收站。

- 文件在回收站中保留一定时间,用户可以选择手动清空回收站,释放存储空间。

* **文件恢复:**

- 用户可以从回收站中恢复误删的文件或文件夹,恢复到原来的位置。

* 相关接口说明

* 获取回收站文件列表:查询回收站中的文件信息。

* 恢复文件:将文件从回收站移动到原路径。

* 清空回收站:删除回收站中的所有文件。

* 功能实现

- 文件删除时,将文件信息插入回收站表,并更新文件表中的状态字段。

- 文件恢复时,更新文件表中的状态字段和路径字段,但是还有前其他业务逻辑

- 文件彻底删除时,从文件关联表中删除文件信息,物理删除,但是file表不去操作

**愿景:"IT路上的持续充电平台,让技术不再难学"**

**更多高级课程请访问 xdclass.net**

### 第十八章 AI网盘回收站设计和编码开发实战

#### 第1集 网盘回收站需求背景和业务逻辑讲解

**简介: 网盘回收站需求背景和业务逻辑讲解**

* 业务需求

* **文件删除:**

- 用户删除文件或文件夹时,系统并非真正删除数据,而是将其移动到回收站。

- 文件在回收站中保留一定时间,用户可以选择手动清空回收站,释放存储空间。

* **文件恢复:**

- 用户可以从回收站中恢复误删的文件或文件夹,恢复到原来的位置。

* 相关接口说明

* 获取回收站文件列表:查询回收站中的文件信息。

* 恢复文件:将文件从回收站移动到原路径。

* 清空回收站:删除回收站中的所有文件。

* 功能实现

- 文件删除时,将文件信息插入回收站表,并更新文件表中的状态字段。

- 文件恢复时,更新文件表中的状态字段和路径字段,但是还有前其他业务逻辑

- 文件彻底删除时,从文件关联表中删除文件信息,物理删除,但是file表不去操作

#### 第2集 当前用户的个人回收站文件列表开发实战

**简介: 当前用户的个人回收站文件列表开发实战**

* 需求

* 用户查看个人回收站的文件

* 注意

* 回收站只显示删除的对应的层级文件,不可进入对应的子文件夹

* 文件删除的时候是逻辑删除,只是修改了del字段状态

* 业务逻辑

* 根据账号查找del=1状态的文件记录

* 如果是文件夹,就只显示文件夹,不显示文件夹里面的文件和文件夹

* **关键:需要提取全部删除文件的ID,然后过滤下,如果某个文件的的父ID在这个文件ID集合里面,则不显示**

* 编码实战

```

@Override

public List

#### 第2集 当前用户的个人回收站文件列表开发实战

**简介: 当前用户的个人回收站文件列表开发实战**

* 需求

* 用户查看个人回收站的文件

* 注意

* 回收站只显示删除的对应的层级文件,不可进入对应的子文件夹

* 文件删除的时候是逻辑删除,只是修改了del字段状态

* 业务逻辑

* 根据账号查找del=1状态的文件记录

* 如果是文件夹,就只显示文件夹,不显示文件夹里面的文件和文件夹

* **关键:需要提取全部删除文件的ID,然后过滤下,如果某个文件的的父ID在这个文件ID集合里面,则不显示**

* 编码实战

```

@Override

public List #### 第5集 网盘回收站还原文件或者文件夹设计

**简介: 网盘回收站还原文件或者文件夹设计**

* 需求

- 用户可以从回收站中恢复误删的文件或文件夹,恢复到原来的位置。

- 支持批量恢复操作,提高用户操作效率

- 业务逻辑有哪些注意事项考虑?

#### 第5集 网盘回收站还原文件或者文件夹设计

**简介: 网盘回收站还原文件或者文件夹设计**

* 需求

- 用户可以从回收站中恢复误删的文件或文件夹,恢复到原来的位置。

- 支持批量恢复操作,提高用户操作效率

- 业务逻辑有哪些注意事项考虑?

* 业务逻辑

* 检查是否满足:文件ID数量是否合法

* 还原前的父文件和当前文件夹是否有重复名称的文件和文件夹

* 判断文件是否是文件夹,文件夹的话需要递归获取里面子文件ID,才可以进行批量还原

* 检查空间是否足够

* 批量还原文件

* 编码实战

```

@Transactional(rollbackFor = Exception.class)

public void restoreFile(FileRecycleReq req) {

//判断文件ID和用户ID是否合法

List

* 业务逻辑

* 检查是否满足:文件ID数量是否合法

* 还原前的父文件和当前文件夹是否有重复名称的文件和文件夹

* 判断文件是否是文件夹,文件夹的话需要递归获取里面子文件ID,才可以进行批量还原

* 检查空间是否足够

* 批量还原文件

* 编码实战

```

@Transactional(rollbackFor = Exception.class)

public void restoreFile(FileRecycleReq req) {

//判断文件ID和用户ID是否合法

List  **愿景:"IT路上的持续充电平台,让技术不再难学"**

**更多高级课程请访问 xdclass.net**

### 第十九章 AI网盘文件搜索和下载功能开发实战

#### 第1集 网盘搜索功能需求介绍和接口设计说明

**简介: 网盘搜索功能需求介绍和接口设计说明**

* 需求

* 用户可以根据文件名称,搜索网盘相关的文件

* 技术栈采用Mysql, 因此采用普通的Like查询

* 学过ElasticSearch的同学也可以将Mysql数据同步到ES中完成更多搜索

* 课程地址:https://xdclass.net/videoDetailsPage?id=94

* 进阶内容可以让AI读取数据库,完成智搜问答

* 编码实战

```

@Override

public List

**愿景:"IT路上的持续充电平台,让技术不再难学"**

**更多高级课程请访问 xdclass.net**

### 第十九章 AI网盘文件搜索和下载功能开发实战

#### 第1集 网盘搜索功能需求介绍和接口设计说明

**简介: 网盘搜索功能需求介绍和接口设计说明**

* 需求

* 用户可以根据文件名称,搜索网盘相关的文件

* 技术栈采用Mysql, 因此采用普通的Like查询

* 学过ElasticSearch的同学也可以将Mysql数据同步到ES中完成更多搜索

* 课程地址:https://xdclass.net/videoDetailsPage?id=94

* 进阶内容可以让AI读取数据库,完成智搜问答

* 编码实战

```

@Override

public List #### 第2集 认识LLM-为什么可以回答我们的问题?

**简介: 认识LLM-为什么可以回答我们的问题?**

* 什么是LLM

* 是Large Language Model 大语言模型的首字母简写

* LLM是基于深度学习的自然语言处理(NLP)模型,通过海量文本数据训练,能够理解、生成和推理人类语言。

* 其核心能力包括:

- **文本生成**(对话、代码、故事)

- **语义理解**(问答、摘要、分类)

- **推理能力**(逻辑判断、数学计算)

* **为什么大模型可以根据我们的输入回答对应的问题?**

* 核心能力:理解自然语言、生成连贯文本、完成特定任务

* 几个关键点:训练数据、模式识别、概率预测、上下文理解

* **Java类比:类似大家的IDEA/VSCode工具智能代码补全工具,但能力扩展到所有自然语言领域**

* Java程序员熟悉的方式理解LLM的文本补全能力:

* 好比一个拥有超强记忆力的代码补全工具(类似IDE的智能提示,但能力放大1000倍)

* **海量知识库**(相当于训练数据)

- 模型"阅读"过整个互联网的文本(就像你看了JDK所有源码+StackOverflow+GitHub)

- 示例理解:当看到`public static void main(`会自动补全参数`String[] args)`

* **模式识别专家**(类似编译器语法分析)

- 建立了词语/句子的关联规则库

- 示例:看到"北京是中国的",后面大概率接"首都"

* **概率预测器**(类似条件判断的加强版)

```

// 伪代码示意(实际使用概率分布)

String predictNextWord(String context) {

Map

#### 第2集 认识LLM-为什么可以回答我们的问题?

**简介: 认识LLM-为什么可以回答我们的问题?**

* 什么是LLM

* 是Large Language Model 大语言模型的首字母简写

* LLM是基于深度学习的自然语言处理(NLP)模型,通过海量文本数据训练,能够理解、生成和推理人类语言。

* 其核心能力包括:

- **文本生成**(对话、代码、故事)

- **语义理解**(问答、摘要、分类)

- **推理能力**(逻辑判断、数学计算)

* **为什么大模型可以根据我们的输入回答对应的问题?**

* 核心能力:理解自然语言、生成连贯文本、完成特定任务

* 几个关键点:训练数据、模式识别、概率预测、上下文理解

* **Java类比:类似大家的IDEA/VSCode工具智能代码补全工具,但能力扩展到所有自然语言领域**

* Java程序员熟悉的方式理解LLM的文本补全能力:

* 好比一个拥有超强记忆力的代码补全工具(类似IDE的智能提示,但能力放大1000倍)

* **海量知识库**(相当于训练数据)

- 模型"阅读"过整个互联网的文本(就像你看了JDK所有源码+StackOverflow+GitHub)

- 示例理解:当看到`public static void main(`会自动补全参数`String[] args)`

* **模式识别专家**(类似编译器语法分析)

- 建立了词语/句子的关联规则库

- 示例:看到"北京是中国的",后面大概率接"首都"

* **概率预测器**(类似条件判断的加强版)

```

// 伪代码示意(实际使用概率分布)

String predictNextWord(String context) {

Map #### 第3集 大模型发展历程和业内主流LLM讲解

**简介: 大模型发展历程和业内主流LLM讲解**

* 发展历程(重点时间线)

| 阶段 | 时间范围 | 核心突破 | 代表模型 |

| :-------------: | :-------: | :----------------: | :-------------: |

| 早期探索期 | 2015-2017 | RNN/LSTM架构 | ELMo |

| Transformer革命 | 2017 | 自注意力机制诞生 | Transformer论文 |

| 预训练时代 | 2018-2020 | 预训练+微调范式 | BERT, GPT-2 |

| 大模型爆发期 | 2020-2022 | 千亿参数规模 | GPT-3, T5 |

| 多模态时代 | 2023-至今 | 文本+图像+代码融合 | GPT-4, PaLM |

* 早期探索(2017年前)-**习惯称为人工智障**

* **2013-2017:RNN/LSTM 时代**

* 模型:Word2Vec、LSTM、Seq2Seq

* 局限性:难以处理长文本依赖,训练效率低

* **2017:Transformer 革命**

* 里程碑论文 **《Attention Is All You Need》**(Google)提出 **自注意力机制**,解决长距离依赖问题,现代LLM基础。

* 预训练模型崛起(2018-2020)

* **2018:BERT(Bidirectional Encoder)**

* 技术突破:双向上下文建模,掩码语言模型(MLM)。

* 应用:文本分类、问答系统。

* **2018:GPT-1(Generative Pre-trained Transformer)**

* 技术突破:单向自回归生成(Decoder-only)。

* 应用:文本生成、续写任务。

* **2019:GPT-2**

* 参数规模:15亿,展示 **零样本学习**(Zero-shot)能力。

* 争议:因生成虚假新闻风险,OpenAI暂未开源完整模型。

* 千亿参数时代(2020-2022)

* **2020:GPT-3**

* 参数规模:1750亿,**Few-shot 学习** 能力显著提升。

* 标志性应用:代码生成(Codex)、对话系统(ChatGPT前身)。

* **2022:Meta LLaMA**

* 开源模型(7B-65B参数),推动社区生态发展。

* 多模态与垂直化(2023至今)

* **GPT-4**:支持图像输入,逻辑推理能力显著增强。

* **开源社区爆发**:Alpaca、Vicuna、Falcon 等轻量级模型涌现。

* **行业应用**:医疗、法律、编程等垂直领域定制化LLM

* 国内外主流大模型(**每个厂商都有多个大模型产品**)

* 国际主流模型

* **GPT系列**(OpenAI):当前最先进的商业闭源模型

* 地址:https://openai.com/

* **LLaMA**(Meta):开源可商用的先进模型

* 地址:https://ai.meta.com/llama

* **Gemini**(谷歌):多任务协同、搜索整合

* 地址:https://deepmind.google

* 国内主流模型

- **文心一言**(百度):中文理解强、知识图谱融合、多模态生成

- 地址:https://wenxin.baidu.com/

- **通义千问**(阿里云):电商场景优化、代码生成强、多模态交互

- 地址:https://tongyi.aliyun.com/

- **Kimi Chat**(月之暗面):长上下文、数据分析可视化、文档解析

- 地址:https://kimi.moonshot.cn

- **ChatGLM**(智谱):开源可商用、中英双语平衡、轻量化部署

- 地址:https://chatglm.cn/

- **DeepSeek**(深度求索):国货之光,低成本、性能强大的推理大模型

- 地址:https://deepseek.com/

#### 第4集 AI大模型常见的四大分类维度你知多少

**简介: AI大模型常见的四大分类维度你知多少**

* 需求

* 前面介绍了不同的厂商的大模型,每个厂商都有多个大模型产品,有什么分类规则吗?

* 注意:由于有比较多人工智能、机器学习、算法等领域的专业名称,不需要全部都了解,关键的课程接下去会讲

* LLM大语言模型的常见分类维度

* 模型架构维度(类比Java框架设计)

| 类型 | 典型代表 | 特点 | Java类比 |

| :--------------------: | :------: | :---------------: | :-------------------------: |

| **自回归模型**(单向) | GPT系列 | 从左到右生成文本 | 类似`StringBuilder`追加操作 |

| **自编码模型**(双向) | BERT系列 | 理解上下文语义 | 类似`Map`结构双向索引 |

| **混合架构** | T5 | 编码器-解码器结构 | 类似Spring MVC分层架构 |

* 功能用途维度(对应开发需求类型)

| 类型 | 典型场景 | Java开发示例 | 代表模型 |

| :------------: | :------: | :------------------------: | :------------------: |

| **指令大模型** | 需求实现 | 根据描述生成Controller代码 | GPT-4, Claude |

| **推理大模型** | 问题排查 | 分析OOM异常原因 | Code Llama, DeepSeek |

* 参数规模维度(类比系统复杂度)

| 类型 | 参数量级 | 特点 | Java工程类比 |

| :------: | :------: | :--------------------: | :----------------: |

| 基础模型 | <1B | 快速响应,适合简单任务 | 类似工具类Utils |

| 标准模型 | 1B-100B | 通用能力强 | 类似Spring框架 |

| 超大模型 | >100B | 复杂推理能力 | 类似分布式系统集群 |

* 部署方式维度(类比系统架构)

| 型 | 特点 | 适用场景 | Java类比 |

| :------: | :------: | :----------: | :-----------------: |

| 云端API | 按需调用 | 快速接入 | 类似RESTful服务调用 |

| 本地部署 | 数据安全 | 敏感业务系统 | 类似内网服务部署 |

* **功能用途维度思考大模型选择**

* 推理大模型(Reasoning Models)

* **特点**:擅长逻辑推理、数学计算、代码调试

* 典型应用:Java异常堆栈分析、系统设计模式选择建议、算法复杂度优化

```

// 类比Java中的复杂业务逻辑处理

public class MathSolver {

public static void main(String[] args) {

String problem = "已知x+y=15,x-y=3,求x和y的值";

// 模型需要执行类似下面的推理过程:

// 1. 建立方程组

// 2. 联立求解

// 3. 验证结果

}

}

```

* 代表模型:DeepSeek-R1(深度求索)、Google Minerva、GPT-4(OpenAI)

* 指令大模型(Instruction Models)

- **特点**:擅长理解复杂指令,完成多步骤任务

- 典型应用

- 根据需求生成API文档、将用户故事转化为技术方案、自动化测试用例生成

```

// 示例:指令模型处理用户需求

用户输入:

"我需要一个Java方法,接收用户ID列表,返回这些用户的订单总数"

模型输出:

public int getTotalOrders(List

#### 第3集 大模型发展历程和业内主流LLM讲解

**简介: 大模型发展历程和业内主流LLM讲解**

* 发展历程(重点时间线)

| 阶段 | 时间范围 | 核心突破 | 代表模型 |

| :-------------: | :-------: | :----------------: | :-------------: |

| 早期探索期 | 2015-2017 | RNN/LSTM架构 | ELMo |

| Transformer革命 | 2017 | 自注意力机制诞生 | Transformer论文 |

| 预训练时代 | 2018-2020 | 预训练+微调范式 | BERT, GPT-2 |

| 大模型爆发期 | 2020-2022 | 千亿参数规模 | GPT-3, T5 |

| 多模态时代 | 2023-至今 | 文本+图像+代码融合 | GPT-4, PaLM |

* 早期探索(2017年前)-**习惯称为人工智障**

* **2013-2017:RNN/LSTM 时代**

* 模型:Word2Vec、LSTM、Seq2Seq

* 局限性:难以处理长文本依赖,训练效率低

* **2017:Transformer 革命**

* 里程碑论文 **《Attention Is All You Need》**(Google)提出 **自注意力机制**,解决长距离依赖问题,现代LLM基础。

* 预训练模型崛起(2018-2020)

* **2018:BERT(Bidirectional Encoder)**

* 技术突破:双向上下文建模,掩码语言模型(MLM)。

* 应用:文本分类、问答系统。

* **2018:GPT-1(Generative Pre-trained Transformer)**

* 技术突破:单向自回归生成(Decoder-only)。

* 应用:文本生成、续写任务。

* **2019:GPT-2**

* 参数规模:15亿,展示 **零样本学习**(Zero-shot)能力。

* 争议:因生成虚假新闻风险,OpenAI暂未开源完整模型。

* 千亿参数时代(2020-2022)

* **2020:GPT-3**

* 参数规模:1750亿,**Few-shot 学习** 能力显著提升。

* 标志性应用:代码生成(Codex)、对话系统(ChatGPT前身)。

* **2022:Meta LLaMA**

* 开源模型(7B-65B参数),推动社区生态发展。

* 多模态与垂直化(2023至今)

* **GPT-4**:支持图像输入,逻辑推理能力显著增强。

* **开源社区爆发**:Alpaca、Vicuna、Falcon 等轻量级模型涌现。

* **行业应用**:医疗、法律、编程等垂直领域定制化LLM

* 国内外主流大模型(**每个厂商都有多个大模型产品**)

* 国际主流模型

* **GPT系列**(OpenAI):当前最先进的商业闭源模型

* 地址:https://openai.com/

* **LLaMA**(Meta):开源可商用的先进模型

* 地址:https://ai.meta.com/llama

* **Gemini**(谷歌):多任务协同、搜索整合

* 地址:https://deepmind.google

* 国内主流模型

- **文心一言**(百度):中文理解强、知识图谱融合、多模态生成

- 地址:https://wenxin.baidu.com/

- **通义千问**(阿里云):电商场景优化、代码生成强、多模态交互

- 地址:https://tongyi.aliyun.com/

- **Kimi Chat**(月之暗面):长上下文、数据分析可视化、文档解析

- 地址:https://kimi.moonshot.cn

- **ChatGLM**(智谱):开源可商用、中英双语平衡、轻量化部署

- 地址:https://chatglm.cn/

- **DeepSeek**(深度求索):国货之光,低成本、性能强大的推理大模型

- 地址:https://deepseek.com/

#### 第4集 AI大模型常见的四大分类维度你知多少

**简介: AI大模型常见的四大分类维度你知多少**

* 需求

* 前面介绍了不同的厂商的大模型,每个厂商都有多个大模型产品,有什么分类规则吗?

* 注意:由于有比较多人工智能、机器学习、算法等领域的专业名称,不需要全部都了解,关键的课程接下去会讲

* LLM大语言模型的常见分类维度

* 模型架构维度(类比Java框架设计)

| 类型 | 典型代表 | 特点 | Java类比 |

| :--------------------: | :------: | :---------------: | :-------------------------: |

| **自回归模型**(单向) | GPT系列 | 从左到右生成文本 | 类似`StringBuilder`追加操作 |

| **自编码模型**(双向) | BERT系列 | 理解上下文语义 | 类似`Map`结构双向索引 |

| **混合架构** | T5 | 编码器-解码器结构 | 类似Spring MVC分层架构 |

* 功能用途维度(对应开发需求类型)

| 类型 | 典型场景 | Java开发示例 | 代表模型 |

| :------------: | :------: | :------------------------: | :------------------: |

| **指令大模型** | 需求实现 | 根据描述生成Controller代码 | GPT-4, Claude |

| **推理大模型** | 问题排查 | 分析OOM异常原因 | Code Llama, DeepSeek |

* 参数规模维度(类比系统复杂度)

| 类型 | 参数量级 | 特点 | Java工程类比 |

| :------: | :------: | :--------------------: | :----------------: |

| 基础模型 | <1B | 快速响应,适合简单任务 | 类似工具类Utils |

| 标准模型 | 1B-100B | 通用能力强 | 类似Spring框架 |

| 超大模型 | >100B | 复杂推理能力 | 类似分布式系统集群 |

* 部署方式维度(类比系统架构)

| 型 | 特点 | 适用场景 | Java类比 |

| :------: | :------: | :----------: | :-----------------: |

| 云端API | 按需调用 | 快速接入 | 类似RESTful服务调用 |

| 本地部署 | 数据安全 | 敏感业务系统 | 类似内网服务部署 |

* **功能用途维度思考大模型选择**

* 推理大模型(Reasoning Models)

* **特点**:擅长逻辑推理、数学计算、代码调试

* 典型应用:Java异常堆栈分析、系统设计模式选择建议、算法复杂度优化

```

// 类比Java中的复杂业务逻辑处理

public class MathSolver {

public static void main(String[] args) {

String problem = "已知x+y=15,x-y=3,求x和y的值";

// 模型需要执行类似下面的推理过程:

// 1. 建立方程组

// 2. 联立求解

// 3. 验证结果

}

}

```

* 代表模型:DeepSeek-R1(深度求索)、Google Minerva、GPT-4(OpenAI)

* 指令大模型(Instruction Models)

- **特点**:擅长理解复杂指令,完成多步骤任务

- 典型应用

- 根据需求生成API文档、将用户故事转化为技术方案、自动化测试用例生成

```

// 示例:指令模型处理用户需求

用户输入:

"我需要一个Java方法,接收用户ID列表,返回这些用户的订单总数"

模型输出:

public int getTotalOrders(List * 案例应用说明

* 金融行业

* 典型需求:合规报告生成、风险评估、反欺诈检测

* 模型选择决策

* 案例代码参考

```

// 使用指令模型生成合规检查代码

String prompt = """

[指令执行] 生成Java方法:

- 输入:交易金额、客户风险等级

- 输出:是否触发反洗钱检查

- 规则:金额>10万或高风险客户必检

""";

// 使用推理模型分析交易模式

String analysisPrompt = """

检测以下交易序列中的异常模式:

2023-01-05 转账50万 → 2023-01-06 购黄金 → 2023-01-07 外汇兑换

请分步骤说明可疑点

""";

```

* 医疗行业

* 典型需求:病历摘要生成、诊断建议、药物相互作用检查

* 模型组合策略

* **指令模型**处理结构化任务:

- 将问诊对话转为标准病历格式

- 生成检查报告模板

* **推理模型**处理复杂场景:

- 鉴别相似病症

- 解释检测指标关联性

* 案例代码参考

```

// 类似伪代码参考

public class MedicalAgent {

@Resource

private InstructionModel reportGenerator; // 指令模型

@Resource

private ReasoningModel diagnosisEngine; // 推理模型

public ProcessResult process(PatientCase input) {

// 第一阶段:结构化处理

MedicalRecord record = reportGenerator.generateRecord(input);

// 第二阶段:智能分析

DiagnosisResult result = diagnosisEngine.analyze(record);

return new ProcessResult(record, result);

}

}

```

* **优先选择指令大模型的场景**

* **客户服务**:

* 任务:自动回复咨询、处理标准化请求(如订单查询)

* 优势:快速生成自然对话,理解用户意图

* **内容生成**:

* 任务:营销文案撰写、社交媒体内容生成

* 优势:保证语言流畅性和创意性

* **优先选择推理大模型的场景**

* **金融分析**:

- 任务:财务报表解读、投资组合风险推导

- 案例:通过链式推理分析“某公司负债率上升对股价的影响路径”

* **科研与工程**:

- 任务:数学建模、实验数据分析

- 示例:推导“气候变化对区域降雨量的非线性影响方程”

* **选择不同功能类型的大模型注意事项**

* **指令大模型的局限**:

* 对隐含逻辑任务(如“预测A→B→C的连锁反应”)可能生成看似合理但缺乏严谨推导的答案。

* **推理大模型的陷阱**:

- 需验证中间步骤(如数学符号是否正确),避免“自信的错误”(如GPT-4可能错误使用公式但语气肯定)。

* **混合部署建议**:

- 前端用指令模型交互,后端用推理模型处理复杂任务(例如客服系统自动转接技术问题到推理引擎)。

* 选择模型的核心原则:

* **任务复杂度**:简单指令→通用模型,深度推理→专用模型

* **容错成本**:高风险场景(如医疗、金融)优先选择可解释性强的推理模型

* **ROI评估**:平衡开发成本(微调/提示工程)与业务收益

* 简单案例方便记忆参考:

- **电商公司**:用指令模型处理客服对话,用推理模型分析用户行为数据。

- **量化基金**:用推理模型推导交易策略,用指令模型生成合规报告。

**愿景:"IT路上的持续充电平台,让技术不再难学"**

**更多高级课程请访问 xdclass.net**

### 第二十一章 LLM大模型核心概念和面试题

#### 第1集 LLM大模型常见核心术语认识第一季

**简介: LLM大模型常见核心术语认识第一季**

* 需求

* 人工智能、大语言模型、机器学习等很多专业术语,没接触过的同学难理解,看博文都懵逼

* 我们这边给大家快速补充基础的概念和术语,通过对比的方式,方便大家看博文资料和课程都方便

* **涉及到比需要更加深入的知识点,我们就会单独的拎一集出来讲解**

* **当前阶段就把课程讲的先理解,然后逐步进阶**

* 常见术语

* Token(标记)

* 相当于自然语言处理的"字节",是文本处理的最小单位(可能是单词/字/标点)

* Java类比:类似`StringTokenizer`分割后的元素

```

// 输入文本:"public static void main"

// Token化结果:["public", "static", "void", "main"]

```

* Transformer(变换器架构)

* 通俗解释:当前最主流的大模型基础架构,通过自注意力机制理解上下文

* Java类比:相当于Java中的`Spring框架`——提供了一套处理文本的通用组件,开发者无需从头写网络结构。

* 自注意力机制(Self-Attention)

* 让模型自动分析文本中每个词与其他词的关系, 类似`Map

* 案例应用说明

* 金融行业

* 典型需求:合规报告生成、风险评估、反欺诈检测

* 模型选择决策

* 案例代码参考

```

// 使用指令模型生成合规检查代码

String prompt = """

[指令执行] 生成Java方法:

- 输入:交易金额、客户风险等级

- 输出:是否触发反洗钱检查

- 规则:金额>10万或高风险客户必检

""";

// 使用推理模型分析交易模式

String analysisPrompt = """

检测以下交易序列中的异常模式:

2023-01-05 转账50万 → 2023-01-06 购黄金 → 2023-01-07 外汇兑换

请分步骤说明可疑点

""";

```

* 医疗行业

* 典型需求:病历摘要生成、诊断建议、药物相互作用检查

* 模型组合策略

* **指令模型**处理结构化任务:

- 将问诊对话转为标准病历格式

- 生成检查报告模板

* **推理模型**处理复杂场景:

- 鉴别相似病症

- 解释检测指标关联性

* 案例代码参考

```

// 类似伪代码参考

public class MedicalAgent {

@Resource

private InstructionModel reportGenerator; // 指令模型

@Resource

private ReasoningModel diagnosisEngine; // 推理模型

public ProcessResult process(PatientCase input) {

// 第一阶段:结构化处理

MedicalRecord record = reportGenerator.generateRecord(input);

// 第二阶段:智能分析

DiagnosisResult result = diagnosisEngine.analyze(record);

return new ProcessResult(record, result);

}

}

```

* **优先选择指令大模型的场景**

* **客户服务**:

* 任务:自动回复咨询、处理标准化请求(如订单查询)

* 优势:快速生成自然对话,理解用户意图

* **内容生成**:

* 任务:营销文案撰写、社交媒体内容生成

* 优势:保证语言流畅性和创意性

* **优先选择推理大模型的场景**

* **金融分析**:

- 任务:财务报表解读、投资组合风险推导

- 案例:通过链式推理分析“某公司负债率上升对股价的影响路径”

* **科研与工程**:

- 任务:数学建模、实验数据分析

- 示例:推导“气候变化对区域降雨量的非线性影响方程”

* **选择不同功能类型的大模型注意事项**

* **指令大模型的局限**:

* 对隐含逻辑任务(如“预测A→B→C的连锁反应”)可能生成看似合理但缺乏严谨推导的答案。

* **推理大模型的陷阱**:

- 需验证中间步骤(如数学符号是否正确),避免“自信的错误”(如GPT-4可能错误使用公式但语气肯定)。

* **混合部署建议**:

- 前端用指令模型交互,后端用推理模型处理复杂任务(例如客服系统自动转接技术问题到推理引擎)。

* 选择模型的核心原则:

* **任务复杂度**:简单指令→通用模型,深度推理→专用模型

* **容错成本**:高风险场景(如医疗、金融)优先选择可解释性强的推理模型

* **ROI评估**:平衡开发成本(微调/提示工程)与业务收益

* 简单案例方便记忆参考:

- **电商公司**:用指令模型处理客服对话,用推理模型分析用户行为数据。

- **量化基金**:用推理模型推导交易策略,用指令模型生成合规报告。

**愿景:"IT路上的持续充电平台,让技术不再难学"**

**更多高级课程请访问 xdclass.net**

### 第二十一章 LLM大模型核心概念和面试题

#### 第1集 LLM大模型常见核心术语认识第一季

**简介: LLM大模型常见核心术语认识第一季**

* 需求

* 人工智能、大语言模型、机器学习等很多专业术语,没接触过的同学难理解,看博文都懵逼

* 我们这边给大家快速补充基础的概念和术语,通过对比的方式,方便大家看博文资料和课程都方便

* **涉及到比需要更加深入的知识点,我们就会单独的拎一集出来讲解**

* **当前阶段就把课程讲的先理解,然后逐步进阶**

* 常见术语

* Token(标记)

* 相当于自然语言处理的"字节",是文本处理的最小单位(可能是单词/字/标点)

* Java类比:类似`StringTokenizer`分割后的元素

```

// 输入文本:"public static void main"

// Token化结果:["public", "static", "void", "main"]

```

* Transformer(变换器架构)

* 通俗解释:当前最主流的大模型基础架构,通过自注意力机制理解上下文

* Java类比:相当于Java中的`Spring框架`——提供了一套处理文本的通用组件,开发者无需从头写网络结构。

* 自注意力机制(Self-Attention)

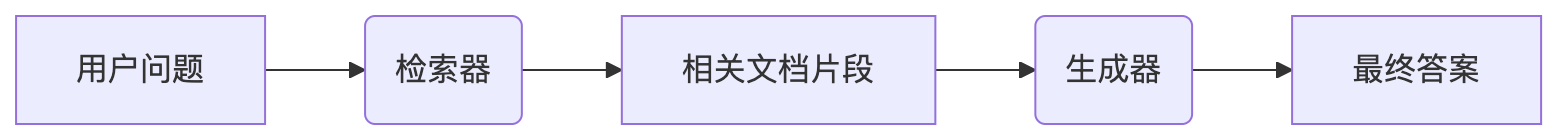

* 让模型自动分析文本中每个词与其他词的关系, 类似`Map * 什么是LLM里面的token

* Token 是文本的基本单位,用于将文本分解为模型能够处理的最小单元

* 在大语言模型中,通过对输入文本进行 Token 化,将文本转换为模型可以理解的数字表示形式,以便模型进行处理和生成输出。

* 作用